생성 AI를 활용한 NCS 직무능력 평가를 위한 자동문항생성 방법론 연구 : GPT4-o 기반 정보보호 분야 침해사고 분석 능력단위 중심

초록

본 연구는 대규모 언어모델인 ChatGPT-4o를 활용하여 NCS 정보보안 분야 능력단위의 직무수행능력 평가문항을 자동으로 생성하고 품질을 개선하는 방법론을 제안하였다. NCS 능력단위요소를 생성모델 기반으로 재정의하고, 평가문항 생성을 위한 프롬프트를 최적화하였으며, 자동 생성된 문항의 품질을 평가 및 개선하는 피드백 프로세스를 자동화하였다. 제안 방법론을 통해 실무 상황을 반영한 변별력 있는 평가문항을 자동으로 개발할 수 있음을 확인하였다. 본 연구는 NCS 기반 직무능력 평가의 고도화를 위한 생성AI 기술활용 가능성을 제시하였다는 점에서 의의가 있다.

Abstract

This study proposed a methodology for automatically generating and improving the quality of job performance assessment items for NCS information security capability units using a large language model, ChatGPT-4o. The NCS competency unit elements were redefined based on the generative model, prompts for generating evaluation items were optimized, and the feedback process for evaluating and improving the quality of automatically generated items was automated. The proposed methodology confirmed the feasibility of automatically developing discriminative evaluation items reflecting practical situations. This study is meaningful in that it presented the possibility of utilizing generative AI technology for the advancement of NCS-based job competency assessment.

Keywords:

Generative AI, NCS job competency, Competency Evaluation, Automatic Question Generation(AQG), Incident Analysis키워드:

성 AI, NCS 직무능력, 역량평가, 자동문항생성, 침해사고 분석1. 서론

1.1 연구 배경 및 필요성

정보보안 분야는 급변하는 사이버 위협 환경에 효과적으로 대응할 수 있는 실무 역량을 갖춘 인재 양성이 필요하다. 한국인터넷진흥원(KISA)의 ‘2023년 하반기 사이버 위협 동향 보고서’에 따르면, 2023년 침해사고 건수는 전년 대비 12% 증가한 1,277건을 기록했다. 특히 상반기에는 전년 동기 대비 40% 증가한 664건의 사고가 발생했다[1]. 이러한 통계는 사이버 공격이 점차 정교화되고 대규모화되는 추세를 보여주며, 정보보안 전문가의 역할, 특히 ‘침해사고 분석’ 능력의 중요성이 증대되고 있음을 보여준다.

국가직무능력표준(National Competency Standards, 이하 NCS)에서는‘침해사고 분석’과 같은 직무능력단위와 관련하여 국가적 차원에서 능력단위를 표준화하였다[2,3]. 공공기관 및 공기업을 중심으로 NCS기반의 직무능력 평가를 채용 과정에 활용되고 있으나, 평가 문항 개발 과정에서 시간, 비용, 전문 인력 등의 제약이 존재한다. 특히 최신 보안 위협과 기술을 반영한 평가 문항을 지속적으로 개발하고 개선하는 데는 어려움이 존재한다.

본 연구에서는 이러한 문제를 해결하기 위해 대규모 인공지능 언어모델(Large Language Model, 이하 LLM)[4,5]을 활용한 자동 문항 생성 방법론을 제안한다. 이 방법론은 NCS 기반 직무능력 평가의 효율성과 전문성을 높이기 위해 문항생성을 자동화하여, 실전적인 침해사고 분석 및 대응 능력을 갖춘 전문 인력 양성을 위한 효율적인 평가 체계 개발에 기여한다.

1.2 연구 목적

본 연구는 대규모 언어모델(LLM) 중 하나인 OpenAI사의 최신형 모델인 ChatGPT-4o[5]를 활용한다. ChatGPT-4o는 멀티모달 성능이 뛰어나고, 특히 한국어 성능이 GPT-4 대비 91% 이상 향상되는 등 비영어권 언어 처리 능력이 크게 향상되어 다양한 분야에서 유용하게 활용될 수 있다[5].

논 본문에서는 OpenAI사의 최신형 모델인 GPT-4o를 활용하여 NCS 정보보안 분야 ‘침해사고 분석’ 능력단위[3]의 평가 문항을 자동 생성하고 품질을 개선하는 방법론을 제안한다. 구체적인 제안 방법론은 다음과 같다.

- 1) NCS 능력단위의 구성 요소를 분석하여 평가 문항 생성에 필요한 핵심 정보를 추출하고 구조화한다.

- 2) 구조화된 NCS 능력단위 정보를 바탕으로 ChatGPT-4o가 직무 지향적인 평가 문항을 생성하도록 유도하는 프롬프트를 설계한다.

- 3) 자동 생성된 평가 문항의 품질을 검증하고 개선 피드백을 도출하는 자동화 프로세스를 구현한다.

- 4) 3) 과정을 반복하여 생성된 문항의 품질을 개선하고, 최종 평가 문항을 도출하여 활용한다.

이를 통해 NCS 기반 직무능력 평가를 위해 AI 기술을 활용한 자동 문항 생성 방안을 제안하여, 정보보안 분야에 NCS 기반의 실무역량을 갖춘 인력이 양성될 수 있도록 기여하고자 한다.

2. 연구 관련 동향 분석

2.1 국가직무능력표준(NCS) 기반 직무능력 평가

국가직무능력표준(NCS)은 산업 현장에서 요구되는 직무 능력을 국가 차원에서 표준화한 것으로, 각 직무별로 필요한 능력단위와 수행준거, 지식·기술·태도 요소를 정의하고 있다[2]. 이러한 NCS의 특징을 반영하여 대학에서도 마이크로디그리 및 나노디그리 체계를 NCS 기반으로 설계하는 등 다양한 분야에 NCS의 활용이 시도되고 있다[6].

이처럼 NCS 기반 직무능력 평가는 이러한 표준에 따라 개인의 직무 수행 능력을 객관적으로 측정하고 향상시키는 데 활용될 수 있다. 그러나 실제 교육 현장에서는 NCS 기반 직무능력 평가에 어려움을 격고 있다. 이는 NCS 학습모듈이 능력단위별 필요 지식과 기술, 평가 방법 등을 제시하고 있으나, 내용이 추상적이고 모호하여 실제 활용이 어렵기 때문으로 추정된다. 따라서, NCS 학습모듈의 효과성 제고와 실무 역량을 갖춘 인재 양성을 위해서는 보다 구체적이고 실제적인 평가 방안 및 NCS 학습모듈 이용 방안이 필요하다.

본 논문에서 자동문항생성에 활용한 정보보안 분야는 NCS 체계에서 ‘20.정보통신’ 대분류 내 ‘01.정보기술’ 중분류에 속하며, 다양한 능력단위로 세분화되어 있다[2]. 그 중 ‘침해사고 분석’ 능력단위는 정보보안 업무 수행에 필수적인 요소로, 침해사고 발생 시 원인과 과정을 분석하고 대응 방안을 마련하는 능력을 의미한다[3].

‘침해사고 분석’ 능력단위는 크게 ‘분석 기반 조성’, ‘침해사고 원인 분석’, ‘침해사고 대응 및 복구’ 등 3개의 세부 능력단위 요소로 구성된다. 각 항목은 3-4개의 수행준거와 이를 달성하는 데 필요한 지식, 기술, 태도 요소를 포함하고 있다[3]. 현재(24년 6월)를 기준으로 2001060305_19v2버전이 배포되고 있으나, 이 버전은 2019년에 만들어져 2022년에 보완 예정이었지만, 현재까지 개선 반영되지 않고 있다. 따라서 본 논문에서는 LLM을 활용한 자동화된 문제생성을 위해 LLM이 사전에 학습한 지식을 기반으로 기존의 NCS에서 정의된 능력단위요소 및 지식, 기술을 새롭게 구성하여 활용하였다. 태도와 관련된 요소는 온라인 기반의 자동화된 문제 생성을 활용하여 개선하거나 평가/측정하기 어려운 요소이며, 특히 성인을 대상으로 하는 교육과정에 적합하지 않은 요소로 판단하여 본 논문에서는 배제하였다.

2.2 대규모 언어 모델(LLM)과 자동 문항 생성

대규모 언어모델(LLM)은 방대한 텍스트 데이터로 사전 학습된 신경망 모델로, 문맥을 이해하고 자연스러운 텍스트를 생성하는 능력을 갖추고 있다. 딥러닝 기술의 발전으로 Transformer 모델[7]이 등장하였고, 이를 활용한 GPT(Generative Pre-trained Transformer) 모델이 대표적인 예로, 토큰 단위의 자기회귀적 언어모델링 방식으로 학습되며 다양한 자연어처리 태스크에 전이학습될 수 있다. 최근에는 사전학습된 대규모 언어모델을 미세조정하거나 프롬프트로 제어하는 방식으로 출력의 품질을 높이는 연구가 활발히 진행되고 있다[8]. 이처럼 GPT 모델은 지속적으로 고도화되어 최근 ChatGPT-4o 모델에 이르러서는 인간 수준에 근접하는 언어 이해와 생성 능력을 보여주고 있다[4,5].

자동 문항 생성(Automatic Question Generation, AQG)은 주어진 텍스트나 지식 베이스로부터 평가 문항을 자동으로 생성하는 기술로, 초기에는 규칙 기반 방식이나 질의응답(QA) 데이터로부터 템플릿을 추출하는 방식이 주로 활용되었다[9]. 문항 생성을 위해 핵심 용어 추출, 얕은 구문 분석, WordNet 등의 NLP 기술과 언어자원을 활용하여 문제와 오답지를 자동 생성하고, 사용자 사후 편집을 허용하는 방식을 사용하여 자동화 할 경우 문항 생성 시간이 74% 이상 단축된다는 연구 결과도 있다[10]. 기존의 AQG 기술은 주로 텍스트 기반 문항 생성에 국한되어 템플릿 기반의 문항 복제 수준에 머물렀으나, 최근 연구에서는 생성AI를 활용하여 동적 자동평가 체계를 통해 학습자 개개인에 맞춘 개인화된 평가 문항 생성과 관련된 방안도 제시되고 있다[11]. Kıyak, Y. S.[12]는 ChatGPT를 통한 자동생성 질문들이 높은 성취도를 보이는 학생들과 낮은 성취도를 보이는 학생들을 효과적으로 구별할 수 있음을 보여주었으며, 이는 ChatGPT가 시험 문제 개발에서 인공지능 도구로서의 잠재력을 지니고 있음을 시사한다.

프로그래밍 코딩 분야에도 자동화된 코드 생성과 테스트에 관한 연구[13-15]도 진행되고 있는 등 다양한 분야에 있어서 자동화 문항생성과 관련된 연구가 활발히 진행되고 있다.

Seulki, Kim[14]은 생성AI를 통해 프로그래밍 교육에 필요한 코드 자동생성 연구에서 교수학습 전략과 프롬프트 엔지니어링 기법을 적용한 프롬프트를 개발하여 ChatGPT로 맞춤형 교육 자료를 생성하고, 100회 반복 실험과 CodeBERT 분석을 통해 개발된 프롬프트의 우수성(평균 0.940의 코사인 유사도)을 입증하였다. Doughty, J.[15]는 Python 프로그래밍 수업의 다지선다형 질문(MCQs)을 GPT-4와 인간이 만든 결과를 비교한 연구에서는 생성된 결과물의 품질이 비슷하며, 특히 학습 목표와 일치성은 GPT(82.9%)가 인간(67.3%)이 만든 것보다 더 잘 일치하는 것으로 보였다. 이는 전반적으로 생성AI를 활용한 문항 생성이 교육평가의 자동화에 활용될 수 있음을 보여준다.

본 논문에서는 ChatGPT-4o 시스템을 활용하여 NCS 기반 직무능력 평가문항을 자동 생성하는 방법론을 제안하였다. ChatGPT-4o는 대화형 인터페이스를 통해 사용자의 요구사항을 이해하고 관련된 문제를 생성할 수 있는 강력한 도구로 활용될 수 있다. ChatGPT-4o로 생성한 평가 문항의 품질을 자동으로 검증하고 개선하기 위해 전문가 관점에서의 문항 적절성을 평가하기 위해 4가지 평가기준을 구성하여 평가 및 개선사항을 도출하고, 이를 다시 ChatGPT-4o에 프롬프트로 제공하여 문항의 오류를 진단하고 수정하는 피드백을 생성하도록 하였다. 이를 통해 전문가의 직접 개입 없이도 문항 품질을 자동으로 개선해 나갈 수 있는 방법론을 구현하고자 하였다.

3. NCS 평가 문항 자동 생성 방법론

3.1 방법론 개요

본 논문에서는 OpenAI사의 최신형 생성AI 모델인 ChatGPT-4o 언어모델을 활용하여 NCS 정보보안 분야 ‘침해사고 분석’ 능력단위의 평가 문항을 자동 생성하고 품질을 개선하는 방법론을 제안한다.

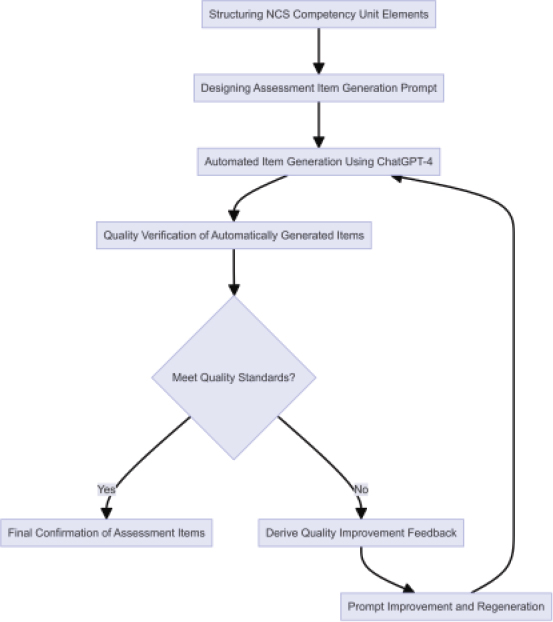

제안 방법론은 크게 NCS 능력단위 요소 구조화, 생성 문항 구조화 및 프롬프트 설계, 자동 생성 문항 품질 개선 프로세스의 단계로 구성된다.

3.2 NCS 능력단위 요소 구조화

평가 문항 자동 생성을 위해 우선 기존 NCS ‘침해사고 분석’ 능력단위인 2011060305_19v2버전의 구성 요소를 분석하고, LLM이 학습한 지식에 기반하여 능력요소를 새롭게 도출하였다. 새롭게 도출한 능력단위 구성요소는 각 수행준거 별로 관련된 지식과 기술을 매핑하였고, 평가에 필요한 평가기준도 능력단위요소 별로 새롭게 도출하였다. [표 1]은 새롭게 구성된 NCS ‘침해사고 분석’ 능력단위 구성요소 중 일부를 나타낸 예시이다. 새롭게 정의된 능력단위 구성요소를 JSON 형태로 구조화하여 LLM에 입력하고, 이를 기반으로 NCS 능력단위 구성요소 별로 수행준거에 기반한 지식과 기술을 측정할 수 있는 문제를 자동으로 생성할 수 있다. 구조화된 형태는 [표 2]와 같다.

3.3 생성 문항 구조화 및 프롬프트 설계

평가 문항은 능력단위요소의 ‘수행준거’에 명시된 지식과 기술을 평가하는 데 초점을 두고 구조화하였다. 문항 유형은 실무 역량 측정에 적합한 ‘객관식 4지선다형’으로 설정하였다.

ChatGPT-4o가 NCS 능력단위의 요구사항에 부합하는 문항을 출제하도록 유도하기 위해 입력 프롬프트를 최적화하였다. 생성형 AI를 활용할때 프롬프트에 대한 입력을 어떻게 하느냐에 따라서 생성되는 데이터의 품질은 크게 변경된다. 이러한 프롬프트 입력에 관한 기술을 프롬프트 엔지니어링이라고 하며, 본 논문에서는 알려진 다양한 프롬프트 엔지니어링 기술을 활용하여, 최적화된 문항 생성이 이루어질 수 있도록 제안한다.

- 1) 페르소나 설정 : 프롬프트 입력시 생성AI의 역할인 페르소나를 명확히 명시해 주는 경우 성능이 향상된다고 알려져 있다. 본 논문에서는 문항 생성시에는 ‘침해사고 분석업무 수행경험이 많은 정보보안 분야 전문가이자 문제출제 전문가’로 문항 품질 평가시에는 ‘한국 NCS 정보보호 분야 전문가이자 문제출제 전문가’로 페르소나를 설정하였다.

- 2) 문항출제 가이드 : NCS 능력단위요소의 수행준거를 바탕으로 정보보안 전문가에게 필요한 지식/기술을 평가할 수 있게 작성하였다.

- 3) 추가 요구사항 : 수험자 간 변별력을 고려하고, 문제의 질문과 보기는 명확하고 이해하기 쉽게 작성되도록 작성하였다.

- 4) 보기구성 요구사항 : 보기만을 통해서 답안을 유추하기 어렵게 하고, 명백한 오답 보기 생성은 피하도록 작성하였다.

- 5) 문항품질 요구사항 : NCS 수행준거 연관성, 문제 난이도와 변별력, 문제 명확성과 이해도, 오답보기 품질 적절성 등 4개 항목의 품질요구사항을 만족하도록 문항생성을 요청하였다.

3.4 자동 생성 문항 품질 개선 프로세스

ChatGPT-4o로 생성된 평가 문항이 프롬프트에서 요구한 생성 기준에 따라 정확히 생성되었는지 확인이 필요하다. 생성AI는 환각과 같은 단점이 존재하며, 아직까지 성능측면에 있어서 인간을 대체할 수 있는 수준의 생성이 이루어지는지 100% 확신할 수 없기 때문이다. 따라서 본 논문에서는 AI 기반으로 자동으로 생성된 문항의 품질에 대해서 품질을 평가하고 개선하는 프로세스를 제안한다. 품질 평가 및 개선 또한 생성AI를 활용하여 자동화된 형태의 프로세스를 구현하였다. 이를 통하여, 문항의 생성부터, 검증, 개선 까지 하나의 사이클을 통해서 생성AI 기반의 자동 생성 문항에 대한 품질을 크게 개선할 수 있다.

문항 품질 검증을 위한 평가 기준과 피드백 방식은 다음과 같이 구성된다. ‘NCS 수행준거와의 연관성’, ‘문제의 난이도와 변별력’, ‘문제의 명확성과 이해도’, ‘오답 보기의 적절성’ 등 4대 기준에 따라 생성 문항의 적절성을 각각 25점 척도씩 총 100점으로 진단하고, 감점 사유와 개선 방안을 제시하도록 한다.

[그림 1]는 이러한 피드백 기반 자동 문항 생성 및 품질 고도화 프로세스 전체를 도식화한 것이다. 자동 평가 결과를 바탕으로 프롬프트를 개선하고 문항을 재생성하는 과정을 반복함으로써, NCS 수행준거에 기반한 직무와 연계된 문항 생성 자동화 할 수 있도록 하였다.

4. 자동화 생성 및 결과

4.1 자동화 생성 실험 조건

제안 방법론의 효과성을 검증하기 위해 수정된 NCS 정보보안 분야 ‘침해사고 분석’ 능력단위(24v3)를 대상으로 평가 문항 자동 생성 실험을 수행하였다. 자동화 생성AI 모델은 ChatGPT-4o 버전을 활용하였고, 각 문항생성 및 개선 프롬프트는 매번 API 호출을 통해 새롭게 요청하였다. 이는 생성AI 의 평가를 품질하는 다른 평가방법과 유사한 형태의 실험 진행 방법이다.

실험은 (1) NCS 능력단위 요소 기반 13개 문항 생성(프롬프트 개선 전), (2)프롬프트 개선 및 피드백 반영을 통한 13개 문항의 반복적 품질 고도화 의 2가지 절차로 진행되었다. 생성된 13개 문항은 반복적 품질 고도화를 7회까지 수행 하였으며, 프롬프트 개선 전 버전(NT0), 프롬프트 개선 버전(NT1), 피드백 반영 버전(NT2~NT8) 7개 등, 총 9개의 버전(NT0~NT8)으로 구성되었다.

4.2 자동화 생성 및 문항 품질 검증 수행

자동화된 문제 생성을 위하여 3.3절에서 제안한 문제 생성과 관련된 주요 구성요소를 반영하여 제안한생성 프롬프트는 [표3]과 같다. 대괄호 {} 에 있는 영문변수는 3.2절에서 제시한 구조화된 JSON 형태의 NCS 능력단위구성요소들의 명칭이다.

생성된 문항에 대한 문항 품질 검증 평가를 위하여 3.4절에서 제안한 문항 품질 검증 기준 및 피드백을 적용하여 문항을 생성하고 검증을 수행하였다.

[표4]는 이러한 문항 품질 검증 평가 기준에 대한 평가 및 개선을 위한 피드백 생성을 위한 프롬프트이다.

평가 결과 도출된 개선사항은 프롬프트에 반영되어 문항을 재생하여 반복적으로 품질을 개선해 나가게 된다. [표 5]는 프롬프트를 통해 생성된 출력을 JSON포멧으로 구조화하여 나타낸 것이다.

[표 6]은 NCS 능력단위 요소만으로 생성한 초기 문항(NT0)과 프롬프트 개선을 거쳐 생성한 문항(NT1), 그리고 문항 개선 피드백을 반영하여 자동화 반복 생성한 문항(NT2~NT8)의 품질 평가 결과를 정리한 것이다. 문항 품질 평가결과는 ‘NCS 수행준거와의 연관성’, ‘문제의 난이도와 변별력’, ‘문제의 명확성과 이해도’, ‘오답 보기의 적절성’등 4개 척도의 합계 점수이다.

실험 결과, NCS 능력단위 요소만으로 생성한 초기 문항의 품질(NT0)은 평균 81.2점으로 비교적 양호한 수준을 보였으며, 프롬프트를 개선한(NT1)결과 82.2점으로 1점 상승한 것을 확인할 수 있다.

프롬프트 개선 및 피드백 반영을 통해 문항의 품질이 지속적으로 향상되는 경향을 보였다. 특히, ‘문항의 실무 상황 반영도’와 ‘변별력’ 측면에서 긍정적인 변화가 관찰되었다. 특히 문항의 실무 상황 반영도와 변별력 측면의 개선이 확인되었다.

총 13개 문항 중 8개 문항에서 품질 향상이 관찰되었으며, 최종 문항 품질은 평균 84.0점까지 향상되었다. ‘NCS 수행준거와의 연관성’, ‘문제의 명확성 및 이해도’ 부문을 중심으로 개선이 이루어졌다.

하지만, 품질평가 점수는 생성AI를 통해 측정한 결과치로, 실험을 반복한 결과 매번 동일한 수치가 나오지 않는 단점이 확인되었다. 따라서 본 논문에서 측정된 수치적인 품질평가 결과 수치는 상대적인 수치로단순 참고용으로 활용하고 실제 본 논문의 방법론을 활용하여 생성된 문항(문제와 보기 구성) 자체에 대해서 세부적으로 살펴봐야 할 것이다. 이는 아직까지 생성AI가 가지는 한계점인 동시에, 향후 생성 AI 모델의 발전과 프롬프트 개선 및 문제 생성 및 평가를 위해 추후 연구 등으로 해결이 가능할 것으로 기대한다.

4.3 생성 문항 개선 전후 품질 평가

평가문항 품질개선을 지속하면서 생성된 문항을 분석한 결과 다음과 같은 특징을 관찰할 수 있었다.

(특징1) 품질개선이 지속될수록 대체적으로 문항의 길이가 길어지는 현상이 발생하였다. (특징2) 실무적인 측면에서의 문항 개선이 일어났다. (특징3) 품질개선을 통해 수정된 질문과 보기를 기준으로 정답선택지의 변경이 일어나는 경우가 있다.

[표 7]는 제안된 방법론을 통해 최종 생성된 ‘침해사고 분석’ 능력단위 평가 문항 중 위에서 관찰된 특징이 반영된 사례 몇 가지를 정리하였다.

사례1은 프롬프트 개선을 통해서 단순한 기술을 묻는 수준에서 실무 수행에 필요한 단계를 묻는 질문으로 개선되었으며, 사례2는 피드백을 1회 수행하여, 수행준거에 기반하여 보기가 조금 더 구체적으로 개선되었다.

사례3는 “(2.3) 침해사고 대응 후 재발 방지를 위한 사후 조치 방안을 마련하고 실행할 수 있다.” 수행준거를 위한 지식(사후 조치 방안, 침해사고 보고 절차) 및 기술(사후 조치 방안 마련 능력, 사후 조치 실행 능력)을 확인할 수 있는 예시로 구체적이고 효과적인 사후 조치방안을 생성하고(NT4, 피드백 3회 수행), 조치 방안에 포함되어야 할 구체적인 법률 조항을 명시하며(NT6, 추가 피드백 2회 수행), 재발 방지 모니터링 및 업데이트 계획(NT7, 추가 피드백 1회 수행)까지 물어보도록 내용이 구체적인 형태로 객관식 문항이 개선된 것을 확인할 수 있었다. 사례4 또한 사례3과 유사한 형태로 총 7회의 피드백을 통해 “(3.3) 침해사고 분석 결과를 바탕으로 향후 대응 전략을 수립하고 실행할 수 있다.”라는 수행준거와 관련된 지식(향후 대응 전략 수립 방법, 침해사고 분석 결과활용 방법) 및 기술(향후 대응 전략 수립 능력, 침해사고 분석 결과활용 능력)을 확인할 수 있는 문항으로 문항이 개선됨을 확인할 수 있었다.

5. 결론

5.1 연구 결과 요약

본 연구는 ChatGPT-4o를 활용하여 NCS 기반 정보보안 직무능력 평가 문항을 자동으로 생성하고 품질을 개선하는 방법론을 제안하였다.

NCS 정보보안 분야 ‘침해사고 분석’ 능력단위 요소를 새롭게 정의하고 구조화 하였으며, 프롬프트 최적화를 통해 평가 문항의 직무 적합성을 제고하는 한편, 자동 품질 검증 및 피드백 반영을 통해 자동으로 생성되는 객관식 문항 출제를 통해 NCS 능력단위 요소에서 요구하는 수행준거에 따른 지식과 기술을 평가할 수 있도록 하였다. 또한, 사례 분석을 통하여 실제 피드백이 지속될수록 실무업무에 기반한 지식 및 기술요소가 생성된 문항에 적용됨을 보였다.

즉, 제안 방법론을 통해 NCS 정보보안 분야 ‘침해사고 분석’ 능력단위 기반의 평가 문항 자동 생성이 가능하였다.

5.2 연구의 시사점 및 의의

본 연구는 대규모 언어 모델(LLM) 기술을 NCS 기반 직무능력 평가 고도화에 접목한 선도적 시도로서 의의가 있다. 제안 방법론은 방대한 분량의 고품질 NCS 평가 문항을 신속하고 효율적으로 개발할 수 있는 가능성을 제시한다.

특히, NCS 능력단위의 수행준거와 관련된 지식 및 기술요소에 기반하여 실무에서 활용 가능한 형태의 질문 및 보기 생성을 통하여 보다 실무 중심적인 문항생성을 자동으로 수행하는 것은 향후 NCS 기반의 직무능력 평가에 많은 도움이 될 것으로 기대한다.

한편, 정략적 측면에서의 객관적인 문항품질 측정을 위해 제안한 부분은 본 논문에서는 크게 의미를 찾기 어려웠다. 하지만, 실제 생성된 문항을 분석한 결과 사례1~4에서 확인할 수 있듯이, 문항 자동 생성 및 개선 피드백 반영이 지속될수록 문항의 내용 및 완성도가 높아지는 것을 확인할 수 있었다. 특히 법률적 조항을 문항에 자동으로 접목하는 부분이나 실제 침해사고 분석 상황을 가정한 구체적 예시를 반영한 문항 자동 생성 결과는 본 연구의 성과 중 하나이다.

향후 본 논문에서 제안한 정략적 측면의 연구와 NCS 능력단위 ‘침해사고 분석’ 이외에 다양 능력단위별 문항생성 등을 통하여 본 방법론을 개선하고 다양한 분야에 제안한 방법론이 활용될 수 있기를 기대한다.

References

- KISA (Korea Internet & Security Agency). (2023). Second Half Cyber Threat Trends Report (KISA Report). Korea Internet & Security Agency.

- HRDK (Human Resources Development Service of Korea). (2024). NCS (National Competency Standards). https://ncs.go.kr

- KRIVET (Korea Research Institute for Vocational Education and Training). (2019). NCS Module: Incident Analysis (2001060305_19v2). Korea Research Institute for Vocational Education and Training. https://ncs.go.kr/unity/th03/ncsResultSearch.do

-

OpenAI. (2023). GPT-4 Technical Report. OpenAI.

[https://doi.org/10.48550/arXiv.2303.08774]

- OpenAI. (2024). GPT-4o. https://openai.com/index/hello-gpt-4o, /

-

Kim, J.S., Lee, K.C., & Choi, S.Y.(2022). NCS based Leveled Micro-Degree Certification Model for Training Practical Cyber Security Experts. Journal of The Korea Society of Computer and Information, 27(8), 123-133.

[https://doi.org/10.9708/jksci.2022.27.08.123]

-

Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A. N., Kaiser, Ł., & Polosukhin, I. (2017). Attention is All You Need. Conference on Neural Information Processing Systems (NIPS 2017).

[https://doi.org/10.48550/arXiv.1706.03762]

-

Liu, P., Yuan, F., Fu, J., Jiang, Z., Hayashi, H., & Neubig, G. (2021). Pre-train, Prompt, and Predict: A Systematic Survey of Prompting Methods in Natural Language Processing. arXiv preprint arXiv:2010.15980.

[https://doi.org/10.48550/arXiv.2107.13586]

-

Das, B., Majumder, M., Phadikar, & S. et al. (2021). Automatic question generation and answer assessment: a survey. Research and Practice in Technology Enhanced Learning(RPTEL) 16, 5.

[https://doi.org/10.1186/s41039-021-00151-1]

-

Mitkov, R., & Ha, L. A. (2003). Computer-aided generation of multiple-choice tests. In Proceedings of the HLT-NAACL 03 workshop on Building educational applications using natural language processing - Volume 2 (HLT-NAACL-EDUC ‘03). Association for Computational Linguistics, 17–22.

[https://doi.org/10.3115/1118894.1118897”]

-

Cho, Y.S. (2024). Research on Design for the Assessment System and Knowledge Tracing Methods Based on Generative AI. The Journal of Korean Association of Computer Education, 27(1), 143-156.

[https://doi.org/10.32431/kace.2024.27.1.011]

-

Kıyak, Y. S., Coşkun, Ö., Budakoğlu, I. İ., & Uluoğlu, C.. ChatGPT for generating multiplechoice questions: Evidence on the use of artificial intelligence in automatic item generation for a rational pharmacotherapy exam. European Journal of Clinical Pharmacology, 80(5), 729–735.

[https://doi.org/10.1007/s00228-024-03649-x]

-

Sarsa, S., Denny, P., Hellas, A., & Leinonen, J. (2022). Automatic Generation of Programming Exercises and Code Explanations Using Large Language Models. ICER ‘22, Vol. 1 27–43. ACM.

[https://doi.org/10.1145/3501385.3543957]

-

Seulki Kim. (2023). Developing Code Generation Prompts for Programming Education with Generative AI. The Journal of Korean Association of Computer Education, 26(5), 107–117.

[https://doi.org/10.32431/KACE.2023.26.5.009]

-

Doughty, J., Wan, Z., Bompelli, A., Qayum, J., Wang, T., Zhang, J., Zheng, Y., Doyle, A., Sridhar, P., Agarwal, A., Bogart, C., Keylor, E., Kultur, C., Savelka, J., & Sakr, M. (2024). A Comparative Study of AI-Generated (GPT-4) and Human-crafted MCQs in Programming Education. Proceedings of the 26th Australasian Computing Education Conference, 114–123.

[https://doi.org/10.1145/3636243.3636256]

Appendix

부 록

· 2005년 가천대학교 컴퓨터공학과(공학사)

· 2007년 숭실대학교 컴퓨터공학과 (공학석사)

· 2013년 숭실대학교 컴퓨터공학과 (공학박사)

· 2012년 ~ 현재 한국인터넷진흥원 보안교육운영 팀장

관심분야 : 정보보호, 정보보호 인력양성, 생성 AI, 역량평가, 침해사고 대응·분석, 인증

j30231@gmail.com