다중 스펙트럼 CNN 기반 고해상도 컬러 영상 보간 기법

초록

본 연구에서는 다중 스펙트럼 컨볼루션 신경망(CNN)을 활용하여 고해상도 컬러 이미지 보간을 수행하는 혁신적인 기법을 제안한다. 이 방법은 저해상도 이미지를 고해상도로 변환하는 과정에서 발생하는 색상 왜곡과 디테일의 손실을 최소화하고자 한다. 우리의 CNN 모델은 다양한 스펙트럼 데이터를 입력으로 사용하여 이미지 내의 복잡한 텍스처와 색상의 상관관계를 더 정확하게 파악한다. 이를 통해 더욱 선명하고 자연스러운 색상을 가진 고해상도 이미지를 생성한다. 개선된 성능을 달성하기 위해 초해상도 네트워크는 일반적으로 많은 수의 계층과 매개변수를 포함하며, 이는 모바일 기기에서의 적용을 제한한다. 이 문제를 해결하기 위해, 우리는 모바일 임베디드 시스템을 위한 경량 이미지 초고해상도를 위한 중첩 백 프로젝션 피드백 네트워크를 제안한다. 첫째, 백 프로젝션 피드백 블록과 연결 피드백을 사용하여 네트워크의 다양한 레벨에서의 상세 특징을 효율적으로 학습한다. 둘째, 경량 네트워크에 적합한 중첩 백 프로젝션을 제안하여 복원 오류를 최소화한다. 마지막으로, 융합 주목 모듈을 제안하여 정보가 풍부한 특징에 더 많은 주의를 기울인다. 테스트 결과, 제안된 기법은 기존의 단일 스펙트럼 기반 방법들과 비교하여 향상된 시각적 품질과 색상 정확도를 보여주었다.

Abstract

In this study, we propose an innovative technique to perform high-resolution color image interpolation using a multispectral convolutional neural network (CNN). This method seeks to minimize color distortion and loss of detail that occur in the process of converting low-resolution images to high resolution. Our CNN model uses diverse spectral data as input to more accurately identify complex texture and color correlations within images. This creates high-resolution images with clearer, more natural colors. To achieve improved performance, super-resolution networks typically include a large number of layers and parameters, which limits their application in mobile devices. To solve this problem, we propose a nested back-projection feedback network for lightweight image super-resolution for mobile embedded systems. First, it uses back-projection feedback blocks and connection feedback to efficiently learn detailed features at various levels of the network. Second, we minimize restoration errors by proposing nested back projection suitable for lightweight networks. Finally, we propose a fusion attention module to pay more attention to information-rich features. Experimental results showed that the proposed technique showed improved visual quality and color accuracy compared to existing single spectrum-based methods.

Keywords:

CNN, super resolution, network, deep learning키워드:

컨볼루션 신경망, 초해상도, 네트워크, 딥러닝1. 서론

사물 인터넷 (IoT) 시대에 모바일 임베디드 시스템은 점점 더 복잡해지고 산업, 과학 및 기술 발전에 더 중요해지고 있다. AI와 빅데이터는 모바일 센서의 성능을 향상시키기 위해 복잡한 임베디드 시스템에 사용되는 최근의 화두이다. 동시에 머신러닝은 비즈니스 혁신과 전환을 위해 대규모 이기종 데이터를 처리하는 데 널리 사용되어왔다. 머신러닝은 AI를 달성하는 방법이고, 딥러닝은 머신러닝을 위한 기술이라 할 수 있다.

딥러닝은 대량의 데이터로 훈련된 컨볼루셔널 신경망을 말하며 현재 최선의 초고해상도를 달성하는데 중요한 도구이다. 딥러닝을 기반으로 한 단일 이미지 초해상도는 저해상도(low resolution: LR) 이미지 데이터의 계층적 표현을 학습하여 고해상도(high resolution: HR) 이미지를 복원하는 것을 목표로 한다. 본 논문에서는 초해상도 네트워크에 초점을 맞춘다. 딥러닝 모델을 훈련시키기 위해서는 대량의 데이터가 필요하며 이 데이터에 라벨을 달아주는 과정은 데이터 라벨링이다. 여기에서 비용에 큰 영향을 미치는 요소로는 데이터양, 라벨링 복잡도, 인력 비용, 그리고 디모자이킹의 도메인 특성이 있다. 라벨링해야 하는 데이터의 도메인에 따라 난이도가 달라질 수 있으며, 특정 도메인에 대한 전문 지식이 필요하고, 이는 라벨링 작업의 복잡성과 비용에 직접적인 영향을 미친다.

데이터 라벨링에 드는 비용에는 몇 가지 중요한 요소들이 영향을 미치는데 첫째, 필요한 데이터의 양이 많을수록 비용이 증가하고, 둘째, 라벨링의 복잡성에 따라 더 많은 시간과 노력이 소요될 수 있고, 셋째, 전문적인 라벨링 인력에 대한 비용도 중요한 고려사항이다. 마지막으로, 데이터가 속한 도메인의 특성에 따라 라벨링의 난이도가 달라지며 이는 비용에 직접적인 영향을 미친다.

딥러닝 모델에서 하이퍼파라미터 조정은 모델의 성능을 최적화하기 위해 모델 아키텍처와 관련된 설정 값을 조정하는 프로세스를 말하는데, 이는 모델 학습 과정에 직접적으로 영향을 주는 매개 변수로 본 논문에서는 이 값을 적절히 조정하여 모델의 학습 속도와 품질을 향상시켰다. 또한 그리드 서치, 랜덤 서치, 그리고 베이지안 최적화 기법도 적용하여 오버피팅(Overfitting)과 언더피팅(Underfitting) 등의 문제를 방지하였다.

딥러닝 모델들은 다양한 아키텍처와 특성을 가지고 있으며, 이러한 특성들이 특정 유형의 영상 처리에 더 효과적일 수 있다. 따라서 각각의 모델의 특성을 파악하고 장단점을 분석하여 적절히 이용하여야 한다. 예를 들어 CNN은 영상 인식과 처리에 매우 효과적인 모델인 반면, RNN 및 LSTM은 시계열 데이터나 연속적인 데이터에 적합하다. 또한 Autoencoders는 이미지 압축, 잡음 제거, 차원 축소 등에 사용되고, GAN은 실제와 유사한 이미지를 생성하는 데 사용된다.

제안하는 모델을 설계할 때 레이어 개수, 층, 깊이, 레이어의 크기 등을 결정하는 기준으로 모델의 성능과 학습 속도를 들 수 있다. 하지만 절대적인 정답은 없고 실험을 통해 조정되어야 한다. 특징 추출 능력과 계산 비용 절감을 위해 레이어 개수와 깊이가 정해지고, 인식률 향상을 위해 커널 크기를 정한다. 정보손실을 막기 위해 작은 스트라이드가 사용되었고 풀링은 Max Pooling을, 활성화 함수는 RPReLU를, 그리고 드롭아웃이 적용되었다.

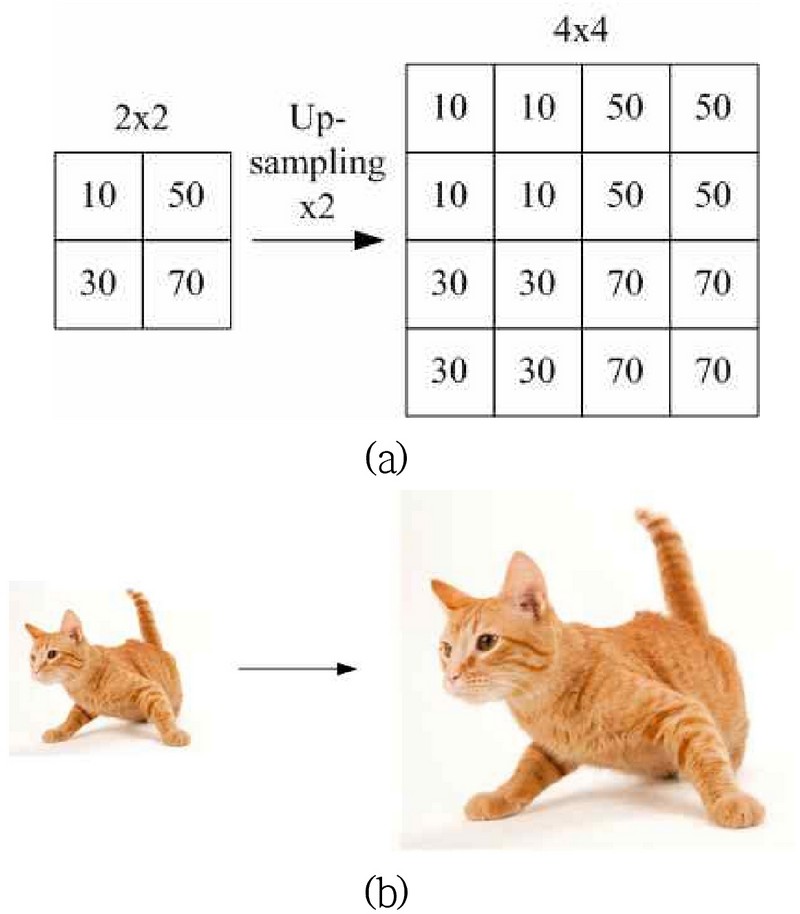

그림 1은 Nearest neighbor를 적용한 초해상도 영상 복원의 예를 도시한다. Nearest neighbor는 데이터 포인트들 사이의 가장 가까운 이웃을 찾는 방법을 말하는데, 기계 학습과 데이터 마이닝에서 자주 사용되는 방법 중 하나이다. 이 방법은 주어진 데이터 포인트에 가장 가까운 훈련 데이터 셋의 포인트를 찾아서, 이를 기반으로 분류나 회귀를 수행한다.

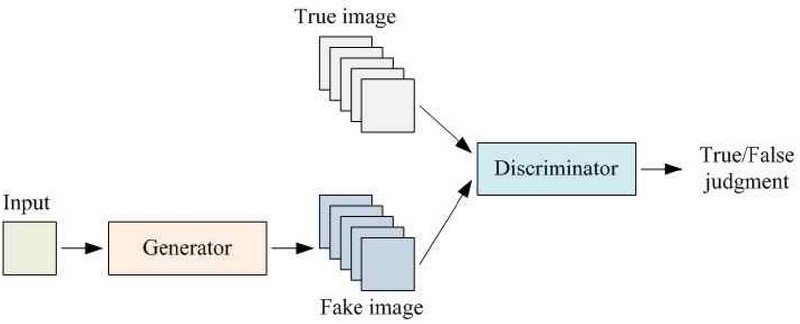

지금까지 많은 초해상도 방법이 제안되었는데, Dong et al.이 제안한 SRCNN [1] Image SR에 처음으로 딥러닝을 도입하여 좋은 성과를 거두었다. 그런 다음 Dong et al.은 Deconvolution을 사용하여 마지막 계층에서 샘플링함으로써 필요한 계산량을 줄인 개선된 버전으로 FSRCNN [2]을 제안했다. Shi et al.은 FSRCNN을 기반으로 하위 픽셀 컨볼루션을 도입하고 중복성을 줄이는 ESPCN [3]을 제안했다. 그런 다음 ResNet [4]에서는 Residual Learning이 제안되었으며, 이는 Gradient Flow를 향상시키고 신경망의 저하를 줄이기 위해 연결을 건너뛰어 레이어를 연결할 수 있다. VDSR [5]은 보간된 LR 이미지를 입력으로 사용하고 심층 네트워크 훈련을 위해 잔차 학습을 도입한 VGG [6] 기반의 20개 레이어 네트워크였다. 한편 잔여 학습을 기반으로 한 몇 가지 다른 방법 [7]이 제안되었다. 잔여 학습을 사용하면 수백 또는 수천 개의 계층으로 구성된 네트워크를 훈련할 수 있다. 그러나 네트워크가 깊어질수록 더 많은 매개변수가 생성되므로 메모리 사용량이 늘어나고 훈련 및 테스트 속도가 느려진다. 이후 DRCN [8] 및 DRRN [9]과 같은 재귀 컨벌루션 네트워크가 제안되었다. 이러한 네트워크의 재귀적 컨벌루션 레이어는 동일한 가중치를 공유하므로 매개변수 수를 늘리지 않고도 네트워크의 깊이를 늘릴 수 있다. SRFBN[10]은 재귀 네트워크에 피드백 메커니즘을 도입하여 LR과 HR 기능의 관계를 효율적으로 학습할 수 있다. Back-projection은 재구성 오류를 최소화하기 위해 많은 연구[10]에서 사용되었다. 주의 메커니즘은 이전 방법 [11]에서 연구되었으며 최근 몇 년 동안 다양한 컴퓨터 비전 작업 [12]에서 사용 및 개선되었다. 그림 2는 생성적 적대 신경망(Generative Adversarial Network: GAN)의 block diagram이다. GAN은 인공지능 분야에서 중요한 발전 중 하나로, 두 신경망이 서로 경쟁하면서 학습하는 구조이다. GAN은 크게 두 부분으로 구성되는데, 생성자와 판별자이다. 전자는 실제 데이터와 유사한 새로운 데이터를 생성하는 역할을 하는데 예를 들어, 실제 고양이 사진과 유사한 고양이 이미지를 만들어내는 것이 목표일 수 있다. 판별자는 제공된 데이터가 실제 데이터인지 아니면 생성자가 만든 가짜 데이터인지를 판별하는 역할을 한다. 판별자는 실제 데이터와 생성자가 만든 데이터를 구별하는 방법을 학습한다. 생성적 적대 신경망은 초해상도를 비롯하여 이미지 생성, 스타일 변환, 음성 합성 등 다양한 분야에서 활용된다.

모바일 센서용 초해상도 기술은 일반적으로 리소스가 제한되어 있기 때문에 매개변수는 적지만 성능은 더 우수한 경량 애플리케이션이 향후 방향이 될 것이다. 따라서 본 논문에서는 SRFBN-S[10] 기반의 모바일 임베디드 시스템을 위한 중첩 역투영 피드백 네트워크를 통한 경량 영상 초해상도를 제안한다.

2. 적용 및 제안 알고리즘

2.1 초해상도에의 딥러닝 적용

SRCNN [1]에서 최초로 초해상도에 딥러닝이 도입된 이후 계산량을 줄이기 위해 마지막 계층에 deconvolution 연산을 도입한 FSRCNN[2]이 제안되었다. ResNet [4]은 경사 흐름을 향상시키고 신경망의 저하를 줄이기 위해 제안되었다. 이를 통해 매우 깊은 네트워크를 통해 고급 성능을 달성할 수 있었다. 이후 DRRN [9], DRCN [8]에서 네트워크 가중치 공유에 필요한 매개 변수를 줄이기 위해 재귀 네트워크가 제안되었고 LapSRN [13]에서는 고해상도 이미지의 서브밴드 잔차를 점진적으로 복원하기 위해 제안되었다. EBRN[14]에서는 재귀적 융합 기술을 사용하여 서로 다른 네트워크 깊이를 통해 서로 다른 주파수의 특징을 추출하고 이를 재귀적으로 통합하였다.

2.2 주의 매커니즘과 피드백 매커니즘

채널 주의 메커니즘을 사용하면 네트워크가 서로 다른 수준으로 서로 다른 채널에 주의를 기울일 수 있다. 이 기술은 Hu 등이 제안한 ‘압착 및 여기’ 모듈과 같은 이미지 분류 작업에 적용되었다 [15]. RCAN [12]에서는 초해상도를 위한 잔여 채널 주의 블록(Residual Channel Attention Block)을 제안했으며, 이러한 블록은 채널 간의 상호 의존 관계를 고려하여 기능을 적응적으로 재조정하였다. 최대 풀링과 평균 풀링을 모두 사용한 채널 주의와 공간 주의가 CBAM [16]에서 제안되었는데, 심층 네트워크의 모든 컨벌루션 블록에서 중간 기능 맵이 개선되었다. CCA(Contrast-Aware Attention) 모듈은 IMDN[17]에서 제안되었고 표준 편차와 평균 풀링의 합을 사용하여 특징 맵에 포함된 전역 정보를 나타낸다.

전통적인 신경망은 피드포워드 신경망이다. 피드포워드 신경망의 출력은 현재 입력과 신경망의 가중치에 의해서만 결정되므로 특히 스케일링 인자가 큰 경우 LR과 HR 이미지 간의 관계를 표현하기가 어렵다. 따라서 피드백 메커니즘이 제안되어 성능개선을 이루고 있다. 최근에는 역투영 단계 간 오류 피드백을 통해 세부적인 특징을 복원하기 위해 역투영 및 오류 피드백 메커니즘이 여러 가지 방법으로 사용되고 있다 [10].

2.3 제안 네트워크의 구조

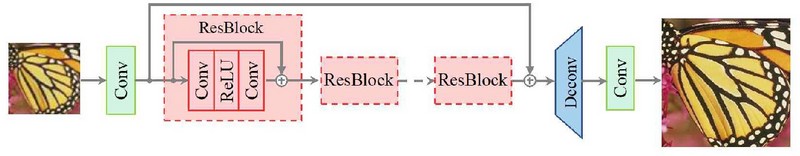

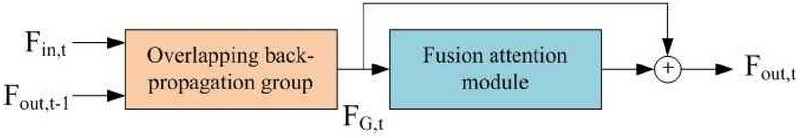

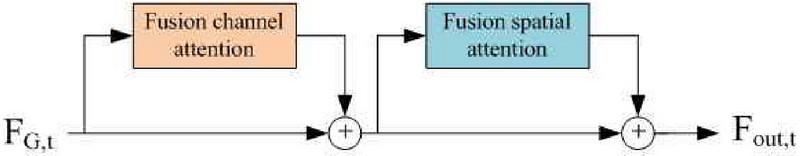

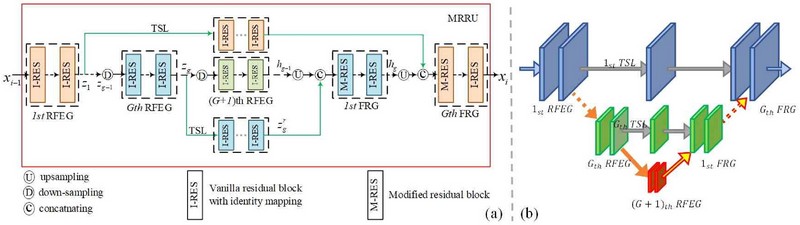

제안 알고리즘은 그림 3을 기반으로 하고, 다음과 같은 요소를 포함하고 있다. 우선 입력 레이어는 저해상도 이미지를 입력으로 받는 역할을 한다. 잔차 네트워크 (Residual Network)는 여러 개의 잔차 블록을 포함하며, 각 블록은 이미지의 특징을 추출하고 학습한다. 이러한 블록들은 고해상도 이미지 복원에 필요한 세부 정보를 학습하는 데 도움이 된다. 피드백 매커니즘 (Feedback Mechanism)은 잔차 네트워크의 출력을 다시 입력으로 사용하여 반복적으로 학습을 진행한다 (그림 4). 이를 통해 네트워크는 점점 더 정확한 고해상도 이미지를 생성할 수 있다. 주의 매커니즘 (Attention Mechanism)은 네트워크가 이미지의 중요한 부분에 집중할 수 있도록 한다 (그림 5). 이 매커니즘은 이미지의 가장 유의미한 특징에 더 많은 가중치를 주어 결과의 품질을 향상시킨다. 마지막으로 출력 레이어는 최종 고해상도 이미지가 생성된다.

위 구조를 기반으로, 이 절에서는 제안 방법의 개요를 설명하고 중첩 역투영 그룹과 융합 주의 모듈을 분석한다. 제안 방법은 피드백 블록, 연결 피드백, 오류 피드백의 3회의 피드백 메커니즘으로 구성되어 있다. T번의 반복을 통해 동일한 배율 인수로 초해상도 영상을 복원한다. 반복 t는 1부터 T까지 순서가 지정되며 마지막 반복의 초해상도 결과가 최종 결과이다. 각 반복 t에 배치된 서브네트워크는 LR 특징 추출 블록, 역투영 피드백 블록 및 재구성 블록의 세 부분으로 구성된다.

| (1) |

D-DBPN [10]에서 영감을 받아 중첩 역투영을 제안하였다. 중첩 역투영은 상향 및 하향 투영 오류를 모두 학습할 수 있으며, 이 오류는 투영 그룹으로 피드백되어 가이드 된다. 제안된 중첩 역투영 프로세스는 기존의 D-DBPN에서 제안된 역투영 단계와 다음 차별성이 있다. 첫째, D-DBPN에서는 각 단위에서 특징을 수정하지만, 단위 내에서 생성된 특징은 폐기되므로 마지막 레이어에서는 마지막으로 수정된 특징 맵만 학습할 수 있다. 그러나 우리의 방법에서는 특징이 단계별로 수정되고 단위 내에서 생성된 특징 맵(예: 중첩된 상향 투사 단위의 영상)은 다른 특징 맵과 연결되어 후자 레이어에서 학습될 수 있다. 둘째, D-DBPN에서는 단위당 하나의 오류 피드백 프로세스만 있지만, 우리 방법에서는 단위당 두 개의 오류 피드백 프로세스가 있다. 마지막으로 D-DBPN에서는 상향 투사단위와 하향 투사 단위가 독립적이지만, 본 방법에서는 하향 투사 단위와 상향 투사 단위가 서로 중첩된다. 이러한 방식으로 오류 역투영에 필요한 계산량과 매개변수를 줄여 경량 네트워크에 적합하게 만든다.

| (2) |

주의 모듈이 있는 네트워크는 낮은 수준의 정보는 무시하고 정보가 풍부한 기능에 집중할 수 있다. 이전 네트워크[12]에서는 평균/최대 풀링이 주의 모듈에 자주 사용되었다. 왜냐하면, 이미지 세부 정보를 향상시키기 위해 고유한 객체에 대한 몇 가지 중요한 정보를 얻을 수 있기 때문이다. 그러나 평균/최대 풀링을 통해 얻은 정보는 매우 적다. 한편 표준편차는 질감, 구조, 모서리에 대한 정보를 얻을 수 있으므로 표준편차가 큰 특징은 정보가 풍부하므로 더 많은 관심을 받아야 한다. 따라서 우리는 네트워크 성능을 향상시키기 위해 평균 풀링, 최대 풀링 및 표준 편차를 융합한다.

비선형 매핑은 그림 6과 같이 다수의 프로세스로 이루어진다. 이 연산을 F라고 표시할 때, 출력 피처는 다음과 같이 계산된다.

| (3) |

제안하는 주의 매커니즘은 이미지의 중요한 부분에 초점을 맞추어 고해상도 변환 과정의 효율성과 정확성을 높이는 데 목적이 있다. 이를 위해 특징 추출과 특징 가중치 조정에 기반한 이미지 재구성을 통해 초해상도 영상을 생성한다. 제안 알고리즘은 네트워크가 이미지의 중요한 부분에 더 많은 주의를 기울여, 더 높은 품질의 고해상도 이미지를 생성할 수 있도록 하는 것이기 때문에 특히 복잡한 배경이나 다양한 객체가 포함된 이미지에서 그 효과가 두드러질 수 있다.

| (4) |

여기에서, BL은 bilinear을 의미한다.

3. 테스트 결과

3.1 테스트 준비

(4)제안한 알고리즘의 성능을 평가하고 이를 기존 방법과 비교하기 위한 성능지표로는 기존 연구에서 널리 채택된 컬러 PSNR (Peak Signal-to-noise ratio) 및 구조적 유사성 지수(Structural Similarity Index Measure: SSIM)를 사용하였다. PSNR은 이미지나 비디오의 원본과 압축된 버전 간의 품질 차이를 측정하는 지표이며, 높은 값은 더 나은 품질을 의미한다. SSIM은 두 이미지의 구조적 유사성을 측정하는 지표이며, 밝기, 대비, 구조 정보를 사용하여 0과 1 사이의 값을 제공한다. 여기에서 1은 완벽한 유사성을 나타낸다.

훈련을 위해 DIV2K [18] 데이터 세트의 이미지를 사용하고 회전 및 자르기를 통해 HR 이미지 수를 10,000개로 확장하였다. 이후에 바이큐빅 다운샘플링을 통해 저해상도 이미지를 얻었다. SRFBN-S [10]와 마찬가지로 T 반복의 평균 L1 손실을 사용하여 네트워크를 최적화하고 마지막 반복에서 SRT를 최종 SR 결과로 사용하였다. 학습률은 초기에 0.0004로 설정되어 있으며 100 Epoch마다 절반으로 줄였다. 옵티마이저로는 Adam을 사용하였고, PyTorch 프레임워크를 사용하여 테스트를 진행했다. 학습 프로세스가 완료된 후 테스트 결과(PSNR 및 SSIM)를 얻고 결과를 최신 방법과 비교하였다.

3.2 컬러 영상 보간 성능 비교

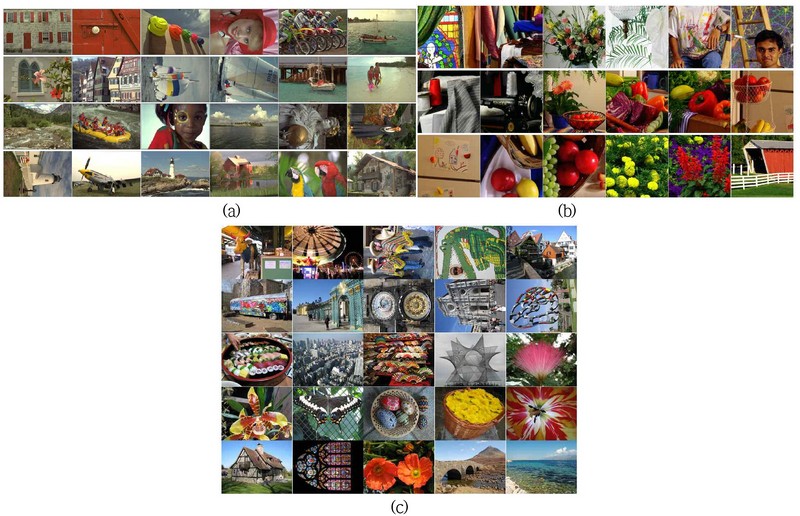

본 테스트에서는 영상 비교에 널리 사용되는 Kodak과 McM 표준 테스트 이미지를 객관적 화질 평가에, LC 표준 테스트 이미지를 주관적 화질 평가에 사용하였다 (그림 7). 결과 비교에 사용된 알고리즘은 표 1과 같다.

PSNR과 SSIM 모두 표 2에 도시한 Kodak과 표 3에 도시한 McM 데이터셋의 결과를 볼 때 가장 좋은 성능을 낸다는 것을 알 수 있다.

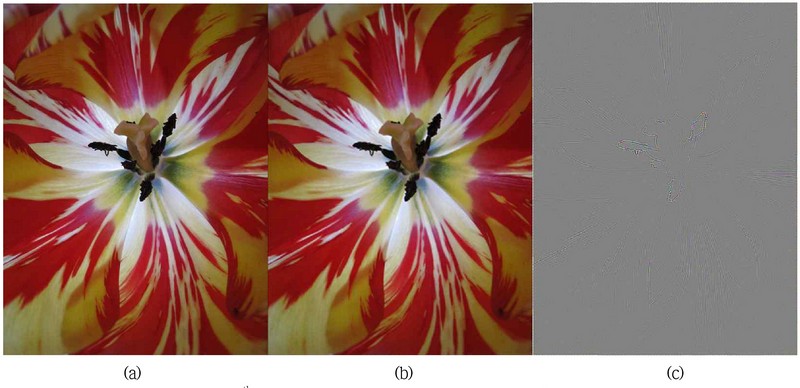

그림 8은 LC 데이터셋의 129번째 영상을 도시한다. 그림 (a)는 원본 영상을, (b)는 복원된 영상을, 그리고 (c)는 (a)와 (b)의 차분치 영상을 보인다. 그림 8(c)를 볼 때 제안 알고리즘을 통해 복원된 영상은 원본과 거의 유사함을 알 수 있다.

4. 결론

본 논문에서는 모바일 임베디드 시스템을 위한 중첩 역투영 피드백 네트워크를 통한 경량 이미지 초해상도를 제안하였다. 제안 네트워크는 모바일 센서의 기능을 향상시키는 데 사용할 수 있는 경량 네트워크로서 우리의 방법에는 초해상도 이미지를 점진적으로 예측하기 위한 T반복이 제시되었다. 우리는 피드백 블록과 연결 피드백을 사용하였다.

제안 네트워트에서는 다양한 수준의 세부 기능을 효율적으로 학습하였다. 이를 위해 적은 계산과 매개변수로 재구성 오류를 최소화하기 위해 중첩 역투영 메커니즘을 제안하였고 정보가 풍부한 기능에 더 많은 관심을 기울이기 위해 융합 주의 모듈을 제안하였다. 벤치마크 데이터 세트에 대한 추가 실험에서는 우리가 제안한 네트워크가 최첨단 경량 방법보다 더 나은 균형을 가지며 모바일 센서를 위한 복잡한 내장 시스템에 적합하다는 것을 보여준다.

결론적으로 본 논문에서는 다양한 이미지 구조에 대해 더 나은 컬러 영상 재구성 작업을 수행할 수 있는 유연한 네트워크가 제안되었다. 또한, 고효율 영상 복원이라는 목적을 달성하기 기존에 제시된 기법을 적응적으로 선택 적용하여 성능을 제고하였다.

Acknowledgments

본 논문은 2023년도 산업통상자원부 및 산업기술기획평가원(KEIT) 연구비 지원에 의한 연구임(‘20025104’)

References

-

Chao D., Chen C., Tang, X. (2014) Learning a deep convolutional network for image super-resolution, Computer Vision, ECCV 2014, 8692, 184-199.

[https://doi.org/10.1007/978-3-319-10593-2_13]

-

Chao D., Tang, X. (2016) Accelerating the super-resolution convolutional neural network, in: Computer Vision, ECCV 2016, 391-407.

[https://doi.org/10.1007/978-3-319-46475-6_25]

-

Shi, W., Caballero, J., Husz´ar, F., Totz, J., Aitken, A. P., Bishop, R., Rueckert, D., Wang, Z. (2016) Real-time single image and video super-resolution using an efficient sub-pixel convolutional neural network, IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 1874-1883.

[https://doi.org/10.1109/CVPR.2016.207]

-

He, K., Zhang, X., Ren, S., Sun, J., (2016) Deep residual learning for image recognition, IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 770-778.

[https://doi.org/10.1109/cvpr.2016.90]

-

Kim, J., Lee, J., Lee, K., (2016) Accurate image super-resolution using very deep convolutional networks, IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 1646-1654.

[https://doi.org/10.1109/CVPR.2016.182]

-

Simonyan, K., Zisserman, A. (2017) Very deep convolutional networks for large-scale image recognition, Conference on Computer Vision and Pattern Recognition (CVPR).

[https://doi.org/10.48550/arXiv.1409.1556]

-

Ledig, C., Theis, L., Husz´ar, F., Caballero, J., Cunningham, A., Acosta, A., Aitken, A., Tejani, A., Totz, J., Wang, Z., Shi, W. (2017) Photo-realistic single image super-resolution using a generative adversarial network, IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 105-114.

[https://doi.org/10.1109/CVPR.2017.19]

-

Kim, J.. Lee, J. K., Lee, K. M. (2016) Deeply-recursive convolutional network for image super-resolution, IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 1637-1645.

[https://doi.org/10.1109/CVPR.2016.181]

-

Tai, Y., Yang, J., Liu, X. (2017) Image super-resolution via deep recursive residual network, IEEE Conference on Computer Vision and Pattern Recognition (CVPR),, 2790-2798.

[https://doi.org/10.1109/CVPR.2017.298]

-

Li, Z., Yang, J., Liu, Z., Yang, X., Jeon, G., Wu, W. (2019) Feedback network for image super-resolution, IEEE Conference on Computer Vision and Pattern Recognition (CVPR).

[https://doi.org/10.1109/CVPR.2019.00399]

-

Mnih, V., Heess, N., Graves, A., Kavukcuoglu, K., Deepmind, G. (2014) Recurrent models of visual attention, 2014.

[https://doi.org/10.48550/arXiv.1406.624]

-

Zhang, Y., Li, K., Li, K., Wang, L., Zhong, B., Fu, Y. (2018) Image super-resolution using very deep residual channel attention networks, European Conference on Computer Vision, 11211, 294-310.

[https://doi.org/10.1007/978-3-030-01234-2_18]

-

Lai, W.-S., Huang, J.-B., Ahuja, N., Yang, M.-H. (2017) Deep laplacian pyramid networks for fast and accurate super-resolution, IEEE Conference on Computer Vision and Pattern Recognition (CVPR).

[https://doi.org/10.1109/CVPR.2017.618]

-

Qiu, Y., Wang, R., Tao, D., Cheng, J. (2019) Embedded block residual network: A recursive restoration model for single-image superresolution, IEEE/CVF International Conference on Computer Vision (ICCV), 4179-4188.

[https://doi.org/10.1109/ICCV.2019.00428]

-

Hu, J., Shen, L., Sun, G. (2018) Squeeze-and-excitation networks, IEEE/CVF Conference on Computer Vision and Pattern Recognition, 7132-7141.

[https://doi.org/10.1109/CVPR.2018.00745]

-

Woo, S., Park, J., Lee, J.-Y., Kweon, I. (2018) CBAM: Convolutional Block Attention Module, 15th European Conference, Munich, Germany, September 8-14, Proceedings, Part VII, 3-19.

[https://doi.org/10.1007/978-3-030-01234-2_1]

-

Hui, Z., Gao, X., Yang, Y., Wang, X. (2019) Lightweight image superresolution with information multi-distillation network, Proceedings of the 27th ACM International Conference on Multimedia, 2024-2032.

[https://doi.org/10.1145/3343031.3351084]

-

Agustsson, E., Timofte, R. (2017) Ntire challenge on single image super-resolution: Dataset and study, IEEE Conference on Computer Vision and Pattern Recognition Workshops (CVPRW), 1122-1131.

[https://doi.org/10.1109/CVPRW.2017.150]

-

Lian, N. X., Chang, L., Tan, Y.P., Zagorodnov, V. (2007) Adaptive filtering for color filter array demosaicking, IEEE Trans. Image Process., 16(10) 2515–2525.

[https://doi.org/10.1109/TIP.2007.904459]

-

Chung, K.-H., Chan, Y.-H. (2006) Color demosaicing using variance of color differences, IEEE Trans. Image Process., 15(10) 2944–2955.

[https://doi.org/10.1109/TIP.2006.877521]

-

Li, J., Randhawa, S. (2009) Color filter array demosaicking using high-order interpolation techniques with a weighted median filter for sharp color edge preservation, IEEE Trans. Image Process., 18(9) 1946–1957.

[https://doi.org/10.1109/TIP.2009.2022291]

-

Pekkucuksen I., Altunbasak, Y. (2012) Edge strength filter based color filter array interpolation, IEEE Trans. Image Process., 21(1) 393–397.

[https://doi.org/10.1109/TIP.2011.2155073]

-

Pei S.-C., Tam, I.-K. (2003) Effective color interpolation in CCD color filter arrays using signal correlation, IEEE Trans. Circuits Syst. Video Technol., 13(6) 503–513.

[https://doi.org/10.1109/TCSVT.2003.813422]

-

Kim, J., Jeon, G., Jeong, J. (2014) Demosaicking using geometric duality and dilated directional differentiation, Optics Communications, 324, 194-201.

[https://doi.org/10.1016/j.optcom.2014.03.021]

-

Gharbi, M., Chaurasia, G., Paris, S., Durand, F. (2016) Deep joint demosaicking and denoising, ACM Trans. Graph., 35(6) 191.

[https://doi.org/10.1145/2980179.2982399]

-

Tan, D. S., Chen, W.-Y., Hua, K.-L. (2018) Deep Demosaicking: Adaptive image demosaicking via multiple deep fully convolutional networks, IEEE Trans. Image Process., 27(5) 2408–2419.

[https://doi.org/10.1109/TIP.2018.2803341]

-

Wu, J., Timofte, R., Van Gool, L. (2016) Demosaicing based on directional difference regression and efficient regression priors, IEEE Trans. Image Process., 25(8) 3862–3874.

[https://doi.org/10.1109/TIP.2016.2574984]

-

Kiku, D., Monno, Y., Tanaka, M., Okutomi, M. (2013) Residual interpolation for color image demosaicking, IEEE International Conference on Image Processing, Melbourne, Australia, 15–18 September 2013; 17, 2304–2308.

[https://doi.org/10.1109/ICIP.2013.6738475]

-

Zhang, L., Wu, X., Buades, A., Li, X. (2011) Color demosaicking by local directional interpolation and nonlocal adaptive thresholding, Journal of Electronic Imaging, vol. 20(2) 016–023.

[https://doi.org/10.1117/1.3600632]

-

Wang, J., Wu, J., Wu, Z., Jeon, G., Jeong, J. (2017) Bilateral Filtering and Directional Differentiation for Bayer Demosaicking, IEEE Sensor Journal, 17(3) 726–734.

[https://doi.org/10.1109/JSEN.2016.2623422]

-

Wang, S., Zhao, M., Dou, R., Yu, S., Liu, L., Wu, N. (2021) A Compact High-Quality Image Demosaicking Neural Network for Edge-Computing Devices, Sensors, 21(9) 3265.

[https://doi.org/10.3390/s21093265]

2002년 조선대학교 우주항공공학과(공학사)

2004년 조선대학교 항공우주공학과 항공우주공학전공(공학석사)

2016년 조선대학교 항공우주공학과 가스터빈전공(공학박사)

2022년 ~ 현재 극동대학교 항공모빌리티학과 조교수

관심분야: 컴퓨터비전, 디지털트윈

E-Mail: habari94@daum.net

1992년 공주대학교 물리학과(이학사)

1999년 충남대학교 물리학과 고체물리학전공(이학석사)

2020년 ~ 현재 극동대학교 에너지IT공학과 조교수

관심분야: 에너지IT, 드론영상분석, 신재생에너지

E-Mail: esther4853@kdu.ac.kr

2023년 극동대학교 에너지I공학과(공학사)

2023년 ~ 현재 극동대학교 대학원 친환경에너지공학과 석사과정

관심분야: 에너지IT, 드론영상분석, 신재생에너지

E-Mail: klhan3091@gmail.com

2017년 인천대학교 전자공학과(공학사)

2023년 인천대학교 임베디드시스템전공(석사과정)

2017년 ~ 현재 (주)위즈윙 부대표

관심분야: 무인항공기, 임베디드시스템

E-Mail: rnd@wiziwng.co.kr