AI 보조교사에 대한 학습자의 질문 양상 분석

초록

본 연구에서는 AI 보조교사와의 상호작용 과정에서 학생들이 생성하는 질문의 유형에 대해, 학년, 과목, 성적, 기기 형태, 물리적 키보드 유무가 미치는 영향을 분석하였다. 연구 결과, 학년이 높아질수록, 성적이 우수할수록 학습과 관련된 질문의 비율이 증가하며, 물리적 키보드가 있는 환경에서도 이와 유사한 경향이 나타났다. 반면, 태블릿 사용 환경과 물리적 키보드가 없는 경우, 학습과 무관한 질문의 비율이 증가하였다. 또한 다항 로지스틱 회귀분석 결과, 학년, 기기 형태, 키보드 유무가 질문 유형에 유의미한 영향을 미치는 것으로 나타났다. 이러한 결과는 AI 보조교사가 학생들의 수준 및 학습 환경에 맞추어 최적화된 피드백을 제공할 수 있도록 설계되어야 함을 시사하며, 특히 저학년 학생과 성적이 낮은 학생들에게는 학습과 관련된 학생들의 질문을 유도하는 전략이 필요함을 보여준다. 본 연구는 AI 보조교사의 도입에 있어 의미있는 시사점을 제공할 것으로 기대한다.

Abstract

This study analyzes the influence of grade level, subject, academic performance, device type, and presence of a physical keyboard on the types of questions generated by students during interactions with AI-assisted teachers. The findings indicate that as grade levels and academic performance increase, the proportion of learning-related questions also rises. A similar trend is observed in environments with physical keyboards. Conversely, in tablet-only settings and environments lacking physical keyboards, the proportion of non-learning-related questions increases. Additionally, a multinomial logistic regression analysis reveals that grade level, device type, and keyboard presence significantly impact question types. These results suggest that AI-assisted teachers should be designed to provide optimized feedback tailored to students' grade levels and learning environments. In particular, strategies to encourage learning-related questions among younger and lowerper-forming students are necessary. This study is expected to provide meaningful insights into the implementation of AI-assisted teachers in educational settings.

Keywords:

AI Tutor, Student-Generated Questions, Generative AI, Question Type Classification, Digital Learning Environment, AI Digital Textbook키워드:

AI 보조교사, 생성형 인공지능, 학생 생성 질문, 질문 유형 분류, 디지털 교육 환경, AI 디지털 교과서1. 서론

“만약 내가 한 시간 동안 문제를 해결해야 한다면 나는 오십오 분을 핵심이 되는 훌륭한 질문을 찾고 결정하는 데 보낼 것이다. 만약 그런 좋은 질문을 내가 찾았다면 나머지 오 분 안에 나는 문제를 해결할 수 있을 것이다.” 앨버트 아인슈타인의 이 말처럼, 질문은 문제 해결의 핵심이며, 학습에서 중요한 역할을 한다. 좋은 질문은 단순한 정보 습득을 넘어, 문제의 본질을 파악하고, 새로운 통찰력을 얻는 데 필수적이다. 학습 과정에서도 학생들이 어떻게 질문하는가는 그들의 학습 수준과 성취도를 반영하는 중요한 지표가 된다[1, 2]. 질문이 학습에서 중요한 역할을 하는 만큼, 학생들이 질문을 생성하는 방식과 유형에 대한 연구도 활발히 이루어져 왔다. Good et al.(1987)의 연구에서는 학생들의 성취도에 따라 질문의 빈도와 유형이 다르다는 점을 밝혔다[3]. 특히 평균 성취도 학생들이 고성취자나 저성취자보다 더 많은 질문을 하는 경향이 있지만, 대부분의 학생들이 생성하는 질문은 여전히 저차원적이고, 사실적 또는 절차적인 성격을 띤다고 하였다. 또한, Chin & Brown(2002)의 연구에서도 학생들이 주로 기본 정보 질문, 특히 절차적 질문에 집중하며, 고차원적인 질문은 상대적으로 드물다는 점을 제시하였다[4]. 이들의 연구 결과에 따르면, 학생들이 문제 해결 과정에서 더 깊이 있는 사고를 촉진하는 고차원적인 질문을 생성하도록 유도하는 것이 학습의 질을 높이는 데 중요한 과제라는 결론을 내렸다. 이처럼 학습 과정에서 학생들의 질문 생성이 중요한 만큼, 생성형 AI 시대에 접어든 현재, 질문의 중요성은 더욱 커지고 있다. 최근 에듀테크 분야에서는 AI를 활용한 다양한 사례들이 등장하고 있으며, 그 중에서도 AI 보조교사는 AI를 기반으로 학생들의 학습을 지원하는 혁신적인 도구로 자리 잡고 있다[5-11]. 실제로 AI 디지털 교과서에도 이러한 AI 보조교사가 도입될 것으로 예상되며, 이는 학생과 AI 간의 상호작용을 통해 학습 경험을 새로운 차원으로 발전시킬 가능성을 보여준다. 그러나 AI 보조교사와 학생들이 어떤 방식으로 대화를 나누고, 학생들이 AI에게 어떤 질문을 하게 될 것인지에 대한 구체적인 연구는 아직 충분히 이루어지지 않은 상황이다.

이에 본 연구에서는 AI 보조교사와 학생 간의 대화에서 학생들이 생성하는 질문의 유형을 분석하고자 한다. 학생들이 GPT 기반의 AI 보조교사와 상호작용하며 생성하는 학생들의 질문 유형을 분류하고, 학년, 과목, 성적, 기기 형태, 물리적 키보드 사용 여부와 같은 요인들이 질문 유형에 미치는 영향을 분석하고자 한다. 구체적으로 다음과 같은 연구 문제를 중심으로 연구를 진행하고자 한다. 먼저 학년과 과목에 따라 학생들이 생성하는 질문의 복잡성이나 수준에 차이가 발생하는지, 학생들의 성취도에 따라 질문의 빈도와 유형에 어떠한 영향을 미치는지 분석하고자 한다. 그리고 학생들이 실제 사용하는 물리적 환경인 태블릿이나 노트북과 같은 기기 형태에 따라 학생들의 질문 생성 방식이 달라지는지, 그리고 물리적 키보드의 유무가 질문의 복잡성이나 형태에 영향을 미치는지를 분석하고자 한다. 본 연구를 통해 학생들이 AI 보조교사와의 상호작용 과정에서 어떤 질문을 던지며, 이러한 질문이 학습 과정과 성취에 어떻게 연결되는지에 대한 시사점을 제공하고자 한다. 특히, AI 기반 학습 도구가 학생들의 사고력과 문제 해결 능력을 강화하기 위해 어떻게 설계되고 적용되어야 하는지를 탐색함으로써, AI 보조교사 도입 시 고려해야 할 사항들을 살펴보고자 한다.

2. 선행연구

2.1 질문의 교육적 의의 및 양상

학생들이 질문을 하는 것은 학습 과정에서 매우 중요한 역할을 하지만 양미경(2002)의 연구 결과에서도 볼 수 있듯이 학교 수업에서 학생들은 거의 질문하지 않는다[12]. 황청일과 임호용(2011)은 학생들이 수업 내용에 대한 질문이 었어도 수업의 분위기에 의해 거의 질문을 하지 않음을 보고하였다[13]. 이지연(2009)은 학생들이 자신이 스스로 할 수 있다고 생각하지 않거나 질문을 받은 사람이 부정적으로 반응할 것을 걱정하는 이유로 인해 질문을 제한하게 된다고 설명하였다[14]. Van der Meij(1988)도 이와 비슷한 맥락에서 학생들이 자신의 능력에 대한 걱정, 다른 사람들의 반응에 대한 우려가 질문을 억제하는 주요 이유가 된다고 언급하였다[15]. 특히, 한국의 경우 체면 문화와 집단 조화를 중시하는 문화적 배경이 질문을 억제하는데 기여한다는 최상진 등(2003)의 연구 결과가 있다[16]. 이들은 타인들의 판단에 대한 두려움으로 인해 학생들이 질문을 던지기를 주저한다고 설명하였다. Dillon(1982)은 학생들이 수업에서 자신의 무지나 혼돈 상태를 드러내는 것을 두려워하며, 이는 그들이 질문을 던지지 않게 만드는 주요 요인이라고 보았다[17]. 이는 학생들이 교실에서 적극적으로 질문을 던지기보다는, 자신의 불확실성을 숨기고 싶어 한다는 것을 시사한다. 한편, 이진규(2016)는 학생들이 질문을 생성하는 것이 단순히 정보를 전달받는 행위가 아니라, 그들이 지식을 구성하고 이를 통해 스스로 학습을 확장할 수 있는 과정이라고 설명하였다[18]. 학생의 질문은 교사에게 학생의 이해 수준을 드러내며, 이를 통해 교사는 학생의 학습을 지원할 수 있는 중요한 단서를 얻게 된다. 김명숙(2015) 역시 지식은 그 자체로 의미를 가지지 않으며, 지식에 내재된 질문-대답의 구조를 통해 의미를 얻는다고 하였다[19]. 전숙경(2010)은 질문이 단순히 답을 찾으려는 노력에 그치지 않고, 그 답에 귀를 기울이는 행위까지 포함한다고 설명하였다[20]. 이는 질문이 학습자와 학습 내용 간의 깊은 상호작용을 가능하게 하며, 학생들이 비판적 사고와 문제 해결 능력을 키우는 데 중요한 역할을 한다는 것을 의미한다. Chin & Brown(2002)은 학생들이 던지는 질문이 지식의 구조를 형성하고, 깊이 있는 사고를 촉진하는 데 필수적인 도구라고 설명하였다[4]. 학생들의 질문은 단순한 사실적 질문에서 고차원적 질문에 이르기까지 다양하며, 이를 통해 그들은 문제 해결 과정에서 더 깊이 사고하게 된다. 특히 고차원적 질문은 학생들이 더 깊이 탐구하고, 추론, 예측 및 문제 해결에 중요한 기여를 한다는 점에서 그 중요성이 크다. 따라서, 학생들의 질문은 단순한 호기심을 넘어서 학습의 질을 높이고 비판적 사고력과 문제 해결 능력을 향상시키는 중요한 역할을 한다. 이를 통해 교사는 학생들의 학습 과정에 대해 더 깊이 이해할 수 있으며, 수업을 보다 효과적으로 구성할 수 있는 기회를 제공받게 된다. 다만 학생들이 질문을 하더라도, 학생들의 질문은 주로 교사의 설명에 대한 보충 설명이나 단순 정보를 묻는 질문이 주를 이룬다고 하였다[21]. 양미경(2002)의 연구 결과에서도 학생들이 제기한 질문의 유형은 단순 정보나 단어의 뜻을 확인하기 위한 질문, 교사가 한 말의 의미를 되묻는 질문이 주로 나타난 것을 볼 수 있다[12]. 최선미와 여상인(2011)의 연구에서도 학생들은 주로 낮은 수준의 질문을 하는 것을 볼 수 있다고 하였으며, 이러한 결과는 학교의 수업이 교과서를 통해 학습 내용의 전달이나 단순한 지식에 치중하고 있음을 나타낸다고 하였다[22].

2.2 학생 생성 질문

Chin & Brown(2002)은 수업에서의 질문을 교수자에 의한 질문과 학생에 의한 질문으로 구분할 수 있으며, 학생들이 스스로 생성한 질문을 학생 생성 질문(Student-generated Questions, SGQ)이라 정의했다[4]. 학생 생성 질문은 학생이 학습의 주체가 되어 지식 구성 과정에 능동적으로 참여하게 하며, 그들의 학습 경험을 더욱 깊이 있게 만든다. 이들은 특히 질문이 학습자의 사고 과정과 지식 확장을 촉진하는 중요한 도구로 작용한다고 강조하였다. 이처럼 학생들은 질문을 통해 자신이 모르는 부분을 명확히 하거나 이해를 넓히며, 교육 내용에 대한 더 깊은 통찰을 얻게 된다. 이 과정에서 학생들은 비판적 사고를 발휘하고, 스스로의 사고 과정을 되짚으며 발전할 수 있게 된다[23]. 또한 Dillon(1988)은 학생 생성 질문이 학습자의 참여도와 흥미를 반영하며, 학생들이 질문을 통해 학습 과정에 더욱 적극적으로 참여하게 된다고 지적했다[24]. 이러한 참여는 학생들의 동기 부여와 더불어 학습의 질적 향상으로 이어지며, 학습 과정에서 긍정적 피드백을 얻는 데도 기여할 수 있다.

학생의 입장에서 질문 생성은 학습 내용에 대한 이해를 심화시키고, 새로운 정보를 습득하며 지식을 창출하는 중요한 과정이다[1]. 이러한 질문 생성 활동은 학생들의 학업 성취도와 자기 효능감에도 긍정적인 영향을 미친다[4]. 성귀복(2020)은 구성주의 교수학습 방법과 교육과정의 확대에 따라 학습자 생성 질문(SGQ)의 교육적 효과에 대한 연구가 점차 중요해지고 있다고 언급했다[25]. 그는 학생들이 스스로 질문을 생성하는 활동이 자기주도 학습 능력과 학업적 자기효능감을 향상시키는 데 기여할 수 있다고 강조한다. 이를 통해 학생들이 학습 과정에서 보다 능동적이고 주체적인 학습자로 성장할 수 있음을 밝혔다. 황청일(2010)은 학생 생성 질문이 교수자로 하여금 학습자의 사전 지식, 개념, 흥미도를 파악할 수 있게 해주며, 학생들은 이러한 질문을 통해 자신의 사전 지식을 활성화할 수 있다고 보았다[26]. 이러한 질문 생성 과정은 학습자들이 자신이 이미 알고 있는 것과 새로운 지식을 연결하고, 그로부터 새로운 통찰을 도출하는 데 도움을 줄 수 있다. Taboada & Guthrie(2006)는 학생 생성 질문이 교사에게 학생의 이해 구조를 파악할 수 있는 도구가 된다고 설명하며, 이는 학생의 학습 과정을 진단하고 그들의 개념적 이해를 도울 수 있는 중요한 지표가 된다고 주장했다[27]. 이와 같이 학생 생성 질문은 학생들이 교과 내용에 대한 깊이 있는 이해를 촉진하며, 학습자와 교수자 간의 상호작용을 더욱 풍부하게 만든다. 정영란과 배재희(2002)는 학생 생성 질문이 학생들로 하여금 분석적이고 비판적인 사고, 소통 및 표현, 창의적 문제 해결을 경험하게 한다고 주장했다[28]. 이처럼 학습자들이 인지적 처리 과정을 통해 학습을 더욱 심화할 수 있게 하며, 학생들은 질문을 통해 자신의 학습 상태를 점검하고 발전시킬 수 있다. 결과적으로, 학생 생성 질문은 교실에서의 효과적인 교수·학습 자원으로 작용한다. 더 나가아 이지연(2017)의 연구에서는 읽기 능력이 우수한 학생일수록 더 수준 높은 질문을 생성할 수 있으며, 이러한 질문은 읽기 평가 도구로 활용될 수 있음을 발견했다[29]. 학생 생성 질문은 학습자의 읽기 능력을 평가하는 데 중요한 지표로 작용하며, 학생들의 이해력과 사고력을 진단하는 중요한 도구로 활용될 수 있음을 시사한다. 이와 같이 학생 생성 질문은 학생들의 참여도, 흥미, 사고력을 증진시키며, 교수자에게는 학생들의 이해도와 학습 상태를 파악하는 중요한 도구로 작용한다. 학생들은 질문을 통해 학습 내용을 심층적으로 탐구하고, 자기주도적 학습 능력을 향상시킬 수 있으며, 교사는 이러한 질문을 통해 수업을 더욱 효율적으로 이끌 수 있다.

2.3 질문 분류틀

학생의 질문을 분석하기 위한 분석틀은 다양한 연구에서 개발되어 사용되고 있다. Good et al(1987)은 학생의 질문을 설명형, 정보형, 절차형, 확인형, 호기심형, 해명형, 기분전환형, 수업관련 관심형, 수업무관련 관심형으로 학생 질문 유형을 분류하였다[3]. Scardamalia & Bereiter(1992)는 학생들이 생성하는 질문을 크게 텍스트 기반 질문과 지식 기반 질문으로 구분하였다. 텍스트 기반 질문은 학생들이 주어진 텍스트나 학습 자료에 대한 이해를 돕기 위해 생성되는 질문이며, 이는 주로 텍스트에 의존하여 발생한다고 보았다. 반면, 지식 기반 질문은 학생의 깊은 관심사나 지식의 공백을 채우기 위한 질문으로, 자연스럽게 또는 자발적으로 발생하며 교육적 잠재력이 더 크다고 밝혔다[30]. Pizzini & Shepardson(1991)은 질문을 입력(input), 처리(processing), 출력(output)의 세 가지 유형으로 분류하였다. 입력 질문은 정보나 데이터를 단순히 회상하거나 감각 자료로부터 도출하는 질문이며, 처리 수준의 질문은 데이터를 바탕으로 관계를 도출하는 데 중점을 두며, 출력 질문은 학생이 데이터를 바탕으로 새로운 방식으로 가설을 세우거나 일반화, 평가를 요구하는 높은 수준의 사고를 반영하는 질문이라고 하였다[31]. 다음으로 White & Gunstone(1992)은 학생들이 자발적으로 고차원적인 사고를 요구하는 질문을 거의 하지 않으며, 학생들이 질문을 처음 생산할 때는 주로 단순한 사실적 질문이 많다는 점을 발견하였다. 학생들은 대부분 한 가지 명확한 답변을 요구하는 질문인 폐쇄형 질문을 하며, 개방형 질문은 상상력과 깊은 사고를 요구하며, 이런 질문은 드물다고 지적하였다[32]. 이 중 다양한 연구에서 질문 분류틀로 사용되고 있는 Chin & Brown(2002)의 연구에서는 학생들이 제시하는 질문을 분석하기 위해 질문을 이원화하여 분류하였다[4]. 해당 연구에서는 학생들이 생성하는 질문을 크게 기본 정보 질문(Basic Information Questions)과 호기심 질문(Wonderment Questions)으로 구분하였다. 기본 정보 질문 (Basic Information Questions)을 사실적 질문(Factual Questions)과 절차적 질문(Procedural Questions)의 2가지 하위범주로 구분하였다. 사실적 질문은 주로 단순한 정보 회상을 요구하는 질문으로, 교과서나 수업 자료에 있는 정보나 간단한 관찰에 대한 질문이라고 보았으며, 이러한 질문은 주로 폐쇄형 질문으로 깊은 사고를 요구하지 않는다고 보았다. 절차적 질문은 특정 절차나 과제가 어떻게 수행되는지에 대한 명확화를 요구하는 질문이며, 이는 주로 단계별 지침을 따르기 위한 질문이다. 호기심 질문은 개념적 이해를 바탕으로 예측, 설명, 응용, 또는 지식 간의 연관성을 탐구하려는 질문으로 더 높은 수준의 사고를 반영하며, 이를 다시 다음과 같이 세분화하였다. 먼저 이해 질문(Comprehension Questions)은 설명을 요구하는 질문으로, 학생이 이해하지 못한 부분을 설명해달라는 요청을 포함된다. 예측 질문(Prediction Questions)은 가설을 세우고 예측하는 질문이며, 이상 탐지 질문(Anomaly Detection Questions)은 학생이 인지한 불일치나 인지적 갈등을 해결하기 위한 질문이라고 보았다. 다음으로 응용 질문(Application Questions)은 학습한 정보를 실제로 어떻게 활용할 수 있을지를 묻는 질문이며, 마지막으로 계획 및 전략 질문(Planning or Strategy Questions) 학생이 문제를 해결하는 과정에서 다음에 무엇을 해야 할지 계획을 세우기 위한 질문이라고 하였다. Chin & Brown(2002)의 연구에 따르면, 기본 정보 질문은 대부분 표면적 학습과 연관되어 있고, 고차원적인 질문은 깊이 있는 학습을 촉진한다고 설명하였다.

2.4 AI 보조교사

생성형 인공지능(Generative AI)은 교육의 여러 측면에 큰 변화를 일으키고 있으며, 개인 맞춤형 학습 지원과 수업 계획 보조 같은 다양한 활용 사례가 연구되고 있다. ChatGPT와 같은 생성형 AI는 학생들에게 맞춤형 피드백과 설명을 제공하여, 개별 학습자의 필요에 맞춘 학습 경험을 제공할 수 있다[5]. 이러한 개인화된 학습 경험은 학생들이 학습 내용을 더 쉽게 이해할 수 있도록 돕고, 실시간으로 피드백을 제공함으로써 학습 효율성을 높인다. 또한, ChatGPT는 교사들이 수업 계획을 세우는 데 도움을 줄 수 있으며, 교사들이 시간과 노력을 절약하여 더 효율적으로 수업을 준비할 수 있게 한다. AI는 학습 자료를 제공하거나 학습자의 요구에 맞춘 자료를 생성함으로써 교사의 업무를 지원하는 도구로서 작용할 수 있다[6]. 이처럼 생성형 AI는 교육에서 교사와 학생 모두에게 더 나은 학습 환경을 제공하는 잠재력을 가지고 있다. 그러나 생성형 인공지능의 기술적 한계와 윤리적 문제도 중요한 고려 사항이다. ChatGPT와 같은 AI 도구는 잘못된 정보를 제공하거나, 편향된 데이터를 학습할 가능성이 있으며, 이는 교육에서 사용될 때 신뢰성 문제를 야기할 수 있다[7]. 또한, 학생들이 AI 도구를 비윤리적으로 사용하거나 부정행위를 저지를 가능성도 존재한다. 따라서 생성형 AI의 교육적 활용에 있어서는 기술적 한계와 윤리적 문제를 충분히 고려해야 한다. 이처럼 이와 같은 도구가 기존 교육 시스템에 미칠 수 있는 영향과 그 사용 방법에 대한 심도 있는 연구가 필요하다[8].

대화형 학습 촉진은 생성형 AI, 특히 ChatGPT의 중요한 기능 중 하나로, 이를 통해 학생들은 더 능동적으로 학습에 참여할 수 있게 된다. ChatGPT는 학습자와 실시간으로 상호작용하면서, 학생들이 즉각적인 피드백을 받을 수 있는 환경을 제공한다. 이러한 상호작용은 학생들이 학습 과정에서 자신의 이해도를 스스로 점검하고, 대화형 학습을 통해 더 깊이 있는 사고를 할 수 있도록 돕는다[9]. 학생들은 ChatGPT와의 대화를 통해 자신이 이해하지 못한 개념을 즉각적으로 확인할 수 있고, 이를 기반으로 학습을 발전시킬 수 있다. 이를 통해 ChatGPT는 능동적 학습을 촉진하고, 교사가 학생들에게 더 나은 피드백을 제공할 수 있는 교사의 보조 도구로도 작용한다. 특히 ChatGPT에 소크라테스식 질문 기법을 적용하여 학생들이 스스로 비판적 사고를 발전시키고 문제 해결 능력을 기를 수 있도록 돕는 연구도 진행되었다[10]. ChatGPT는 학생들에게 질문을 던지고 답변을 제공하는 방식으로 학생들의 호기심을 자극하며, 이는 학습자가 학습에 능동적으로 참여하도록 장려도록 사용될 수 있다. 또한, 형성평가 활동을 통해 ChatGPT는 학생들에게 지속적인 피드백을 제공하고, 개인화된 학습 경험을 제공할 수 있다[11]. 이와 같은 연구들은 ChatGPT와 같은 생성형 AI가 대화형 학습을 촉진함으로써 학생들이 더 능동적이고 자기주도적인 학습자로 성장할 수 있도록 돕는 역할을 할 수 있음을 시사한다.

3. 연구방법

3.1 연구 설계

본 연구에서는 AI 보조교사에 대한 초등학생들의 질문 유형에 영향을 미치는 다양한 요인에 대한 분석을 실시하였으며, 성적, 학년, 과목, 기기 형태, 물리적 키보드 유무를 그 요인으로 설정하였다. 본 연구에서는 과목을 국어, 사회, 과학 과목으로 한정하였으며, AI 디지털 교과서가 향후 3학년부터 적용됨에 따라 학년을 3~6학년으로 선정하였다. 또한 기기형태와 물리적 키보드의 요인은 현장에서 실제 사용되는 환경으로 판단하여 관련 변수로 사용하였다. 본 연구는 학년, 과목, 기기 형태, 키보드 사용 유무, 성적과 같은 변수와 질문 유형과의 관계를 탐구하는 것을 목적으로 한다.

3.2 데이터 수집 및 전처리

본 연구에서 사용된 데이터는 한국 내 초등학교 11개 반의 230명의 학생들을 대상으로 수집되었으며, 학생을 식별할 수 있는 개인 정보는 수집하지 않았다. 학생들은 LLM 기반의 평가 자동 채점 및 AI 보조교사 프로그램인 COCOA Edu (https://cocoaedu.com)을 사용하면서 실제로 제출한 2,480개의 질문 데이터를 사용하였다. COCOA edu는 간편 평가 시스템으로 평가 질문에 대한 학생들의 답변 내용을 바탕으로 자동 채점이 이루어지며, 평가 질문에 대해 학생들이 질문하고 이에 대해 OpenAI의 GPT-4 API 기반의 생성형 인공지능이 답변하는 시스템이다. 분석에 사용된 데이터의 주요 칼럼은 학생이 제출한 질문, 학년, 과목, 사용된 기기 형태(태블릿, 데스크톱/랩탑), 물리적 키보드 가용 여부, 그리고 해당 학생의 성적을 포함한다.

질문 유형 분류를 위해 OpenAI의 GPT-4 API를 사용하여 총 5번에 걸쳐 질문을 분류하였다. 각 질문은 기본 정보 질문(Basic Information Questions), 호기심 질문(Wonderment Questions), 관련 없는 질문(Off-Task Questions)이라는 세 가지 상위 유형 중 하나로 분류되었다. 또한, 기본 정보 질문과 호기심 질문은 각각 하위 카테고리별로 다시 세분화되었다. 기본 정보 질문은 사실적 질문(Factual Questions), 이해 질문(Comprehension Questions), 절차적 질문(Procedural Questions) 등으로 나뉘었고, 호기심 질문은 예측 질문(Prediction Questions), 모순 탐지 질문(Anomaly Detection Questions), 응용 질문(Application Questions), 계획 및 전략 질문(Planning or Strategy Questions) 등의 하위 카테고리로 세분화되었다. 분류 결과를 바탕으로 최빈 카테고리로 질문 유형에 대한 1차 필터링을 실시하였으며, 이후 연구자의 확인을 거쳐 최종적으로 질문 유형을 선택하였다.

3.3 데이터 분석

수집된 데이터는 먼저 기술통계를 통해 전반적인 분포와 비율을 파악하였다. 그리고 교차검증(Chi-square test)을 통해 학년, 과목, 기기 형태, 키보드 유무, 성적과 질문 유형 간의 관계가 유의미한지 확인하였다. 또한, 분산분석(ANOVA)을 통해 학업 성취도에 따른 질문 유형별 차이를 분석하였으며, 다항 로지스틱 회귀분석(Multinomial Logistic Regression)을 통해 학년, 과목, 기기 형태, 키보드 유무가 질문 유형에 미치는 영향을 종합적으로 평가하였다.

3.4 연구 대상

본 연구에서는 총 2,480개의 학생 질문 데이터를 분석하였다. 주요 변수로는 학년, 과목, 기기 형태, 키보드 유무, 질문 유형 및 세부 질문 분류이다. 각 변수에 대한 기술통계 결과는 다음과 같다.

먼저, 학년별 질문 분포는 Table 1과 같으며, 총 2,480개의 질문 중 4학년 학생들로부터 나온 질문이 전체의 49.0%에 해당하는 1,216개로 가장 많았다. 그 다음으로는 6학년 학생들의 질문이 23.9%에 해당하는 592개였으며, 3학년 학생들의 질문은 20.2%에 해당하는 501개로 나타났다. 5학년 학생들이 제출한 질문은 6.9%에 해당하는 171개로, 상대적으로 적은 수를 차지했다.

과목별 질문 분포는 Table 2와 같으며, 과학 과목에서 가장 많은 질문이 이루어졌으며, 이는 전체 질문의 44.4%에 해당하는 1,100개이다. 사회 과목에서는 37.9%에 해당하는 941개의 질문이, 국어 과목에서는 17.7%에 해당하는 439개의 질문이 이루어졌다.

기기 형태에 따른 질문 분포는 Table 3과 같으며, 태블릿PC를 사용하는 학생들로부터 2,099개의 질문이 나와 전체의 84.6%를 차지하였다. 노트북을 사용하는 학생들로부터 나온 질문은 15.4%에 해당하는 381개로 상대적으로 적었다. 이는 실험에 참여한 11개 반 중 태블릿을 사용한 반이 9개반에 해당하기 때문에 이러한 비율로 제시된 것으로 판단된다.

키보드 유무에 따른 질문 분포는 Table 4와 같으며, 물리적 키보드가 없는 기기를 사용하는 학생들이 제출한 질문이 71.4%에 해당하는 1,771개로 대부분을 차지하였고, 키보드가 있는 기기를 사용하는 학생들의 질문은 28.6%에 해당하는 709개로 나타났다. 이는 태블릿 PC를 사용한 9개 반 중 물리적 키보드를 연결하여 사용한 반이 2개 반이 포함되어 있기 때문이다.

질문 유형별 분포를 분석한 결과는 Table 5와 같으며, 기본 정보 질문(Basic Information Questions)이 36.65%에 해당하는 909개로 가장 일반적인 질문 유형이었으며, 관련 없는 질문(Off-Task Questions)은 37.66%에 해당하는 934개로 비슷한 비율을 보였다. 호기심 질문(Wonderment Questions)은 25.69%에 해당하는 637개로 상대적으로 낮았다. 이는 학생들이 학습 과정에서 사실 확인이나 절차적 질문을 주로 하지만, 학습과 무관한 질문도 상당수 존재함을 나타낸다.

마지막으로, 세부 질문 분류는 Table 6과 같으며 사실적 질문(Factual Questions)이 전체의 47.02%에 해당하는 727개로 가장 높은 비율을 차지하였다. 이해 질문(Comprehension Questions)은 30.98%에 해당하는 479개로 나타났으며, 절차적 질문(Procedural Questions)은 11.77%에 해당하는 182개로 확인되었다. 예측 질문(Prediction Questions)은 0.78%에 해당하는 12개로 가장 적었으며, 모순 탐지 질문(Anomaly Detection Questions)은 6.66%에 해당하는 103개, 응용 질문(Application Questions)은 1.75%에 해당하는 27개, 계획 및 전략 질문(Planning or Strategy Questions)은 1.03%에 해당하는 16개로 나타났다. 이 결과는 학생들이 AI 보조교사와의 대화에서, 주로 단순한 사실 확인이나 이해를 돕기 위한 질문을 많이 한다는 것을 보여준다.

4. 연구결과

4.1 변수별 질문 유형 비율 분석

다음으로 학년, 과목, 기기 형태, 키보드 유무, 성적과 같은 주요 변수에 대한 학생들의 질문 유형 비율을 분석하였다. 이 분석은 각 변수에 따라 기본 정보 질문(Basic Information Questions), 호기심 질문(Wonderment Questions), 관련 없는 질문(Off-Task Questions)의 비율이 어떻게 달라지는지를 파악하는 데 중점을 두었다. 분석 결과는 다음과 같다.

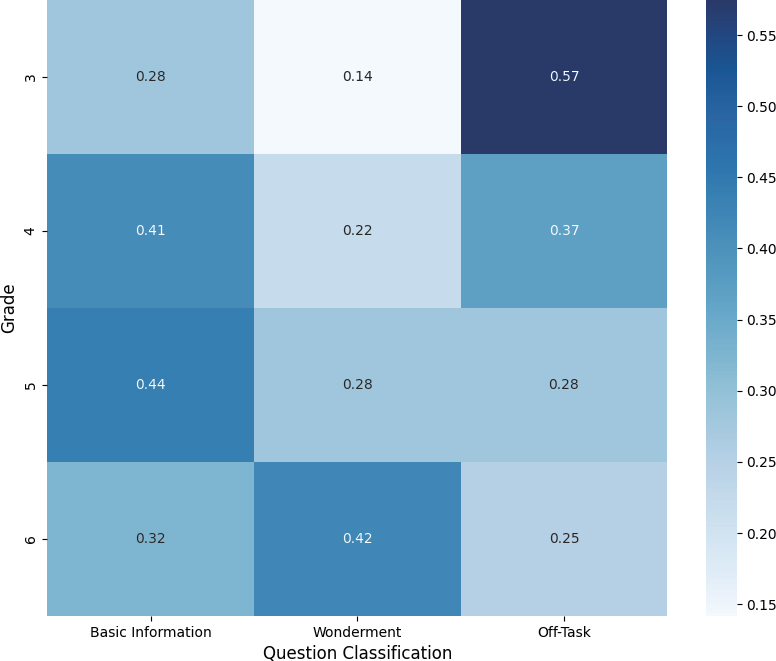

학년별로 학생들이 어떤 유형의 질문을 주로 하는지를 분석한 결과는 Figure 1과 같으며, 학년이 높아짐에 따라 질문 유형의 분포가 변화하는 경향이 나타났다. 3학년 학생들은 관련 없는 질문의 비율이 57%로 가장 높았으며, 이는 낮은 학년일수록 학습과 무관한 질문을 많이 하는 경향을 나타낸다. 반면, 기본 정보 질문과 호기심 질문의 비율은 각각 28%와 14%로 비교적 낮았다. 4학년과 5학년으로 올라가면서 기본 정보 질문의 비율이 증가하였으며, 4학년은 41%, 5학년은 44%로 나타났다. 호기심 질문의 비율도 4학년에서 22%, 5학년에서 28%로 증가하였다. 이는 학년이 올라감에 따라 학생들이 학습 내용에 대해 더 많은 관심과 이해를 가지게 되는 것을 보여준다. 6학년에서는 호기심 질문의 비율이 42%로 가장 높았으며, 관련 없는 질문의 비율은 25%로 감소하였다.

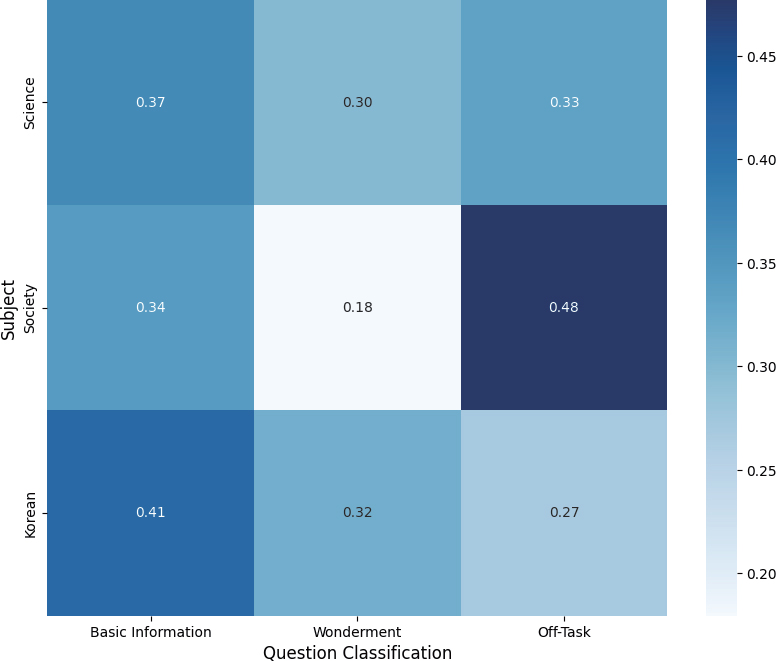

과목별로 학생들이 주로 하는 질문 유형을 분석한 결과는 Figure 2와 같다. 과학 과목에서는 기본 정보 질문이 37%로 가장 높았으며, 호기심 질문이 30%, 관련 없는 질문이 33%로 나타났다. 이는 과학 수업에서 학생들이 주로 정보 확인 및 절차적 질문을 많이 하지만, 여전히 관련 없는 질문도 상당수 존재함을 나타낸다. 사회 과목에서는 관련 없는 질문의 비율이 48%로 가장 높게 나타났으며, 기본 정보 질문과 호기심 질문의 비율은 각각 34%와 18%로 나타났다. 국어 과목에서는 기본 정보 질문의 비율이 41%로 가장 높았고, 호기심 질문이 32%, 관련 없는 질문이 27%로 나타났다.

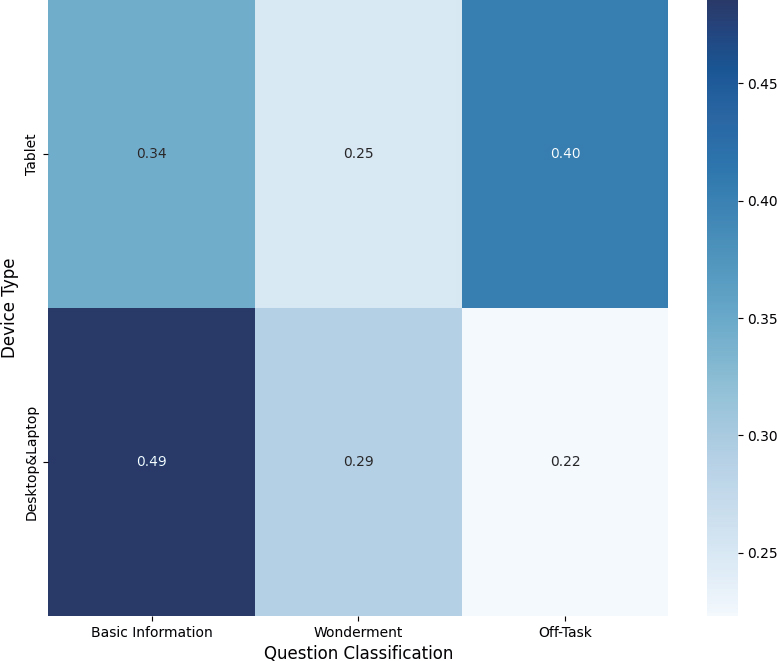

기기 형태에 따른 질문 유형의 비율을 분석한 결과는 Figure 3과 같으며, 태블릿(Tablet)을 사용하는 학생들은 관련 없는 질문의 비율이 40%로 상대적으로 높게 나타났다. 기본 정보 질문의 비율은 34%, 호기심 질문의 비율은 25%로 나타났다. 이는 태블릿을 사용하는 학생들이 학습과 관련이 없는 질문을 상대적으로 많이 한다는 것을 시사한다. 데스크톱/랩탑(Desktop/Laptop)을 사용하는 학생들은 기본 정보 질문의 비율이 49%로 가장 높았으며, 호기심 질문이 29%, 관련 없는 질문이 22%로 나타났다.

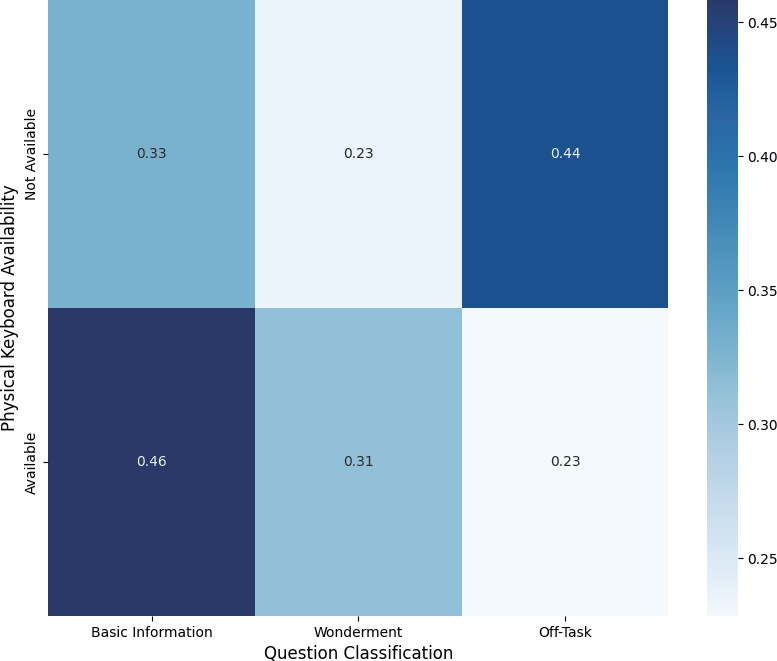

물리적 키보드 유무에 따른 질문 유형의 비율을 분석한 결과는 Figure 4와 같으며, 키보드가 없는 경우 관련 없는 질문의 비율이 44%로 가장 높았으며, 이는 키보드가 없는 기기를 사용하는 학생들이 학습과 관련 없는 질문을 많이 한다는 것을 시사한다. 기본 정보 질문의 비율은 33%, 호기심 질문의 비율은 23%로 나타났다. 반면, 물리적 키보드가 있는 경우 기본 정보 질문의 비율이 46%로 가장 높았으며, 호기심 질문의 비율이 31%, 관련 없는 질문의 비율이 23%로 나타났다.

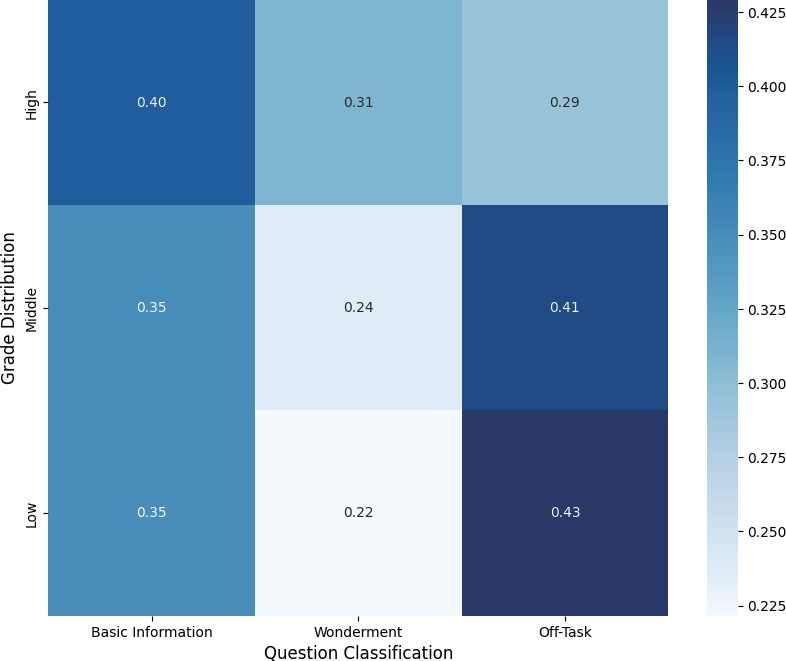

성적 수준에 따른 질문 유형의 비율을 분석한 결과는 Figure 5와 같다. 각 학년별 상위 30%에 해당하는 학생을 상, 하위 30%에 해당하는 학생을 하로 하여 분석을 실시하였으며, 성적이 높은 그룹에서는 기본 정보 질문의 비율이 40%, 호기심 질문의 비율이 31%, 관련 없는 질문의 비율이 29%로 나타났다. 이는 성적이 높은 학생들이 학습과 관련된 질문을 더 많이 하고, 관련 없는 질문을 덜 하는 경향이 있음을 시사한다.

반면, 성적이 낮은 그룹에서는 관련 없는 질문의 비율이 43%로 가장 높았으며, 이는 성적이 낮은 학생들이 학습 중 주제와 무관한 질문을 많이 하는 경향이 있음을 보여준다. 기본 정보 질문과 호기심 질문의 비율은 각각 35%와 22%로 나타났다.

4.2. 교차검증

다음으로 학년, 과목, 기기 형태, 물리적 키보드 유무와 같은 주요 변수들이 질문 유형의 분포에 통계적으로 유의미한 영향을 미치는지를 검토하기 위해 교차검증(Chi-square test)을 실시하였으며 그 결과는 Table 7과 같다.

Chi-square Test Results for Question Type Distribution by Grade, Subject, Device Type, and Keyboard Availability

검증 결과 학년별로 질문 유형의 분포가 유의미하게 달라지는 것으로 나타났다(χ²=191.511, p < .001). 3학년 학생들은 주로 관련 없는 질문을 많이 하였으며, 이는 다른 학년에 비해 통계적으로 유의미하게 높았다. 반면, 6학년 학생들은 호기심 질문을 더 많이 하는 경향이 있었으며, 이 또한 통계적으로 유의미한 차이로 나타났다. 이 결과는 학년이 높아질수록 학습과 관련된 질문을 더 많이 하고, 관련 없는 질문은 줄어드는 경향이 있음을 나타낸다.

검증 결과 과목에 따라 질문 유형이 유의미하게 달라지는 것으로 나타났다(χ²=83.973, p < .001). 과학 과목에서는 기본 정보 질문이 많이 이루어졌으며, 사회 과목에서는 관련 없는 질문의 비율이 통계적으로 유의미하게 높았다. 국어 과목에서는 기본 정보 질문의 비율이 높았다. 이는 과목별 특성에 따라 학생들이 제기하는 질문의 유형이 달라진다는 점을 보여준다.

검증 결과 기기 형태에 따라 질문 유형의 분포가 통계적으로 유의미하게 달라지는 것으로 나타났다(χ²=47.655, p < .001). 태블릿을 사용하는 학생들은 관련 없는 질문을 통계적으로 유의미하게 더 많이 하였으며, 데스크톱/랩탑을 사용하는 학생들은 기본 정보 질문의 비율이 통계적으로 유의미하게 높았다. 이는 기기 형태가 학생들의 학습 집중도 및 질문 유형에 영향을 미칠 수 있음을 나타낸다.

검증 결과 물리적 키보드 유무와 질문 유형 간에도 유의미한 차이가 있는 것으로 나타났다(χ²=92.932, p < .001). 키보드가 없는 경우 관련 없는 질문의 비율이 통계적으로 유의미하게 높았으며, 키보드가 있는 경우 기본 정보 질문과 호기심 질문의 비율이 통계적으로 유의미하게 높았다. 이는 물리적 키보드의 존재가 학생들의 질문 유형에 영향을 미친다는 점을 보여준다.

4.3 성적과 질문 유형의 일원분산분석

추가로 학생들의 질문 유형에 따라 성적에 유의미한 차이가 있는지를 검토하기 위해 일원분산분석(ANOVA)을 실시한 결과는 Table 8과 같다.

분산분석 결과, 질문 유형에 따른 성적에 유의미한 차이가 있는 것으로 나타났다(χ²= 16.766, p < .001). 분석 결과 호기심 질문(Wonderment Questions)을 주로 하는 학생들의 평균 성적이 가장 높았다. 반면, 관련 없는 질문(Off-Task Questions)을 주로 하는 학생들의 평균 성적은 가장 낮았다. 이는 호기심 유형의 질문을 하는 학생들이 학습 내용을 깊이 이해하고 응용하는 역량 또한 높다는 것을 보여주며 기존의 연구 결과와 일치하는 결과를 보이고 있다. 사후 검정으로 Scheffe 테스트를 실시한 결과 또한 관련 없는 질문을 주로 하는 학생들의 성적이 기본 정보 질문 및 호기심 질문을 주로 하는 학생들의 성적보다 통계적으로 유의미하게 낮은 것으로 나타났다.

4.4 다항 로지스틱 회귀분석

다음으로 학생들의 질문 유형을 종속변수로, 학년, 과목, 기기 형태, 키보드 유무를 독립변수로 설정하여 다항 로지스틱 회귀분석을 실시한 결과는 Table 9와 같다. 이 분석은 각 독립변수가 질문 유형에 미치는 영향을 정량적으로 평가하고, 이러한 관계가 통계적으로 유의미한지를 확인하는 데 중점을 두었다.

다항 로지스틱 회귀분석의 모형 적합도를 평가한 결과, 모형 전체의 적합도가 통계적으로 유의미하게 나타났다. 우도비 검정(Likelihood Ratio Test) 결과, 학년(χ²= 114.452, p < .001), 과목(χ²= 10.481, p = .033), 키보드 유무(χ²= 12.523, p = .002)이 유의미한 영향을 미치는 변수로 확인되었다. 반면, 기기 형태는 통계적으로 유의미한 수준에 미치지 못하였다 (χ²= 5.580, p = .061). 모형의 설명력을 나타내는 지표로는 Cox 및 Snell R²값이 0.098, Nagelkerke R²값이 0.111, McFadden R²값이 0.048로 나타났다. 이는 모델이 종속변수의 변동을 설명하는데 어느 정도 기여하고 있음을 시사한다.

다항 로지스틱 회귀분석의 결과는 Table 10과 같으며, 각 독립변수가 기본 정보 질문 및 호기심 질문과 비교하여 관련 없는 질문의 관계를 다음과 같이 해석할 수 있다.

Multinomial Logistic Regression Results for Question Type Comparisons (Basic Information Questions vs. Off-Task Questions and Wonderment Questions vs. Off-Task Questions)

Table 10에서 볼 수 있듯이, 3학년 학생들이 6학년 학생들에 비해 관련 없는 질문에 속할 가능성이 기본 정보 질문에 속할 가능성 보다 높음이 통계적으로 유의미하게 제시되었다(B = -0.637, p < .001). Exp(B) 값은 0.529로, 3학년 학생들은 기본 정보 질문을 할 가능성이 6학년 학생들에 비해 주제와 관련 없는 질문에 비해 약 52.9% 낮으며, 이는 3학년 학생들이 6학년 학생들에 비해 주제와 관련없는 질문을 할 가능성이 더 높음을 나타낸다.

또한 물리적 키보드가 없는 때 물리적 키보드가 있는 경우에 비해, 관련 없는 질문에 속할 가능성이 기본 정보 질문에 속할 가능성보다 유의미하게 낮았다(B = -0.603, p = .001). Exp(B) 값은 0.547로, 물리적 키보드가 없는 경우, 사실적/절차적 질문을 할 가능성이 관련 없는 질문을 할 가능성에 비해 약 54.7% 낮다. 이는 키보드 유무가 학생들의 질문의 질에 중요한 영향을 미칠 수 있음을 나타낸다.

Table 10에서 볼 수 있듯이, 3학년 학생들이 6학년 학생들에 비해 관련 없는 질문에 속할 가능성이 호기심 질문에 속할 가능성보다 높음이 통계적으로 유의미하게 제시되었다(B = -1.658, p < .001). Exp(B) 값은 0.190으로, 이는 호기심 질문에 비해 관련 없는 질문에 속할 가능성이 약 81% 낮다는 것을 나타낸다. 4학년 학생들도 6학년 학생들에 비해 관련 없는 질문에 속할 가능성이 높게 제시되었다(Exp(B) = 0.381, p < 0.001). 5학년 학생의 결과도 4학년 학생의 결과와 유사하게 제시되었다(Exp(B) = 0.522, p = 0.013). 이는 학년이 높아질수록학생들이 호기심 질문을 할 가능성이 증가함을 나타내며, 학년이 올라감에 따라 학생들이 더 깊이 있는 사고와 개념적 이해를 위한 질문을 할 가능성이 높아지는 기존의 연구 결과와 일치한다.

태블릿을 사용하는 학생들도, PC나 랩탑 환경의 학생들보다 관련 없는 질문에 속할 가능성이 호기심 질문에 속할 가능성보다 높음이 통계적으로 유의미하게 제시되었다(B = -0.544, p = .020). Exp(B) 값은 0.580으로, 이는 태블릿을 사용하는 경우 호기심 질문에 속할 가능성이 관련 없는 질문에 비해 약 42% 낮다. 이는 태블릿 사용이 학생들이 더 깊이 있는 호기심 질문을 덜 하고, 상대적으로 관련 없는 질문을 할 가능성을 높일 수 있음을 나타낸다.

5. 결론 및 제언

5.1 결론

본 연구는 AI 보조교사에 대한 초등학생들의 질문 유형에 영향을 미치는 다양한 요인에 대한 분석을 목적으로 하였다. 성적, 학년, 과목, 기기 형태, 물리적 키보드 유무를 주요 변수로 설정하여 분석한 결과, 학년, 과목, 기기 형태, 물리적 키보드 유무, 성적과 같은 변수가 학생들의 질문 유형에 영향을 미친다는 점이 확인되었다. 학년이 높아질수록, 그리고 물리적 키보드가 있는 환경에서는 학생들이 학습과 관련된 질문을 더 많이 하며, 성적이 높은 학생일수록 이러한 경향이 더욱 두드러졌다. 반면, 태블릿을 사용하는 환경과 물리적 키보드가 없는 환경에서는 학습과 관련 없는 질문이 더 많이 나타났다. 교차검증 결과, 학년, 과목, 기기 형태, 키보드 유무, 성적과 같은 주요 변수들이 학생들의 질문 유형에 통계적으로 유의미한 영향을 미쳤다. 성적과 질문 유형 간의 일원분산분석 결과, 학생들이 질문하는 방식과 학습 성과 사이에 밀접한 연관이 있음을 확인하였다. 특히, 호기심이 높은 질문 유형이 높은 성적과 연관되어 있다는 점은 AI 보조교사가 학생들에게 호기심을 자극하는 질문을 할 수 있도록 돕는 가이드라인 개발이 필요함을 시사한다. 마지막으로, 학생들의 질문 유형을 종속변수로, 학년, 과목, 기기 형태, 키보드 유무를 독립변수로 설정하여 다항 로지스틱 회귀분석을 실시한 결과, 학년, 기기 형태, 물리적 키보드 유무가 학생 생성 질문의 유형에 유의미한 영향을 미친 것으로 나타났다.

이러한 결과에 따라 AI 보조교사를 도입할 때 학생들의 학습 환경과 대화 양상을 최적화하여, 학습에 더 집중하고 호기심을 자극할 수 있는 환경을 조성하는 것이 중요하며 그 구체적인 설계 방안은 다음과 같다. 첫째, 학생 특성별로 AI 보조교사의 질문 유도 전략을 설계할 필요가 있다. 연구 결과 성적이 낮은 학생들과 낮은 학년 학년 학생들이 학습 내용과 관련된 질문을 할 가능성이 낮아지는 경향이 확인되었으며, 이는 학생의 고차원적인 학생 생성 질문 유도가 가능한 AI 보조교사를 도입해야 함을 의미한다. 저학년 학생들은 학습의 기초를 다지는 시기이므로, 그들의 질문이 학습 목표와 일치하도록 유도하는 전략이 필요하다. 둘째, 기기 형태가 학생들의 질문 수준에 통계적으로 유의미한 영향을 미치므로, 학생들에게 제공하는 기기에 대한 가이드라인을 제공할 필요가 있다. 연구 결과, 태블릿을 사용하는 환경에서는 학습과 관련 없는 질문이 많아지는 경향이 나타났다. 이는 태블릿의 시각적 및 감각적 요소들이 학생들의 집중도를 떨어뜨릴 수 있음을 보여준다. 따라서, 태블릿 사용 시 학생들의 집중력을 유지할 수 있는 환경적 조치나 교육적 전략이 필요하다. 셋째, 연구 결과 물리적 키보드의 유무도 학생들의 질문 수준에 중요한 영향을 미치므로 태블릿 기기를 제공할 때 지급하는 주변기기에 대한 가이드라인을 제공할 필요가 있다. 연구 결과 물리적 키보드가 없는 환경에서는 학습과 관련 없는 질문이 더 많이 발생하는 경향이 있었다. 이는 키보드의 부재가 학생들의 학습 참여도를 저하시킬 수 있음을 시사한다. 따라서, 태블릿을 사용하는 학습 환경에서는 물리적 키보드를 제공함으로써 학습의 질을 높일 수 있는 방안을 고려해야 한다. 다만 본 연구는 특정 플랫폼에서의 학습자들의 질문을 바탕으로 분석한 결과라는 연구의 제한점이 있다.

5.2 제언

다음으로 AI 보조교사를 활용한 학습 환경에서 교육적 전략 수립에서의 시사점 및 연구의 제언은 다음과 같다. 첫째, 학생들의 호기심 질문을 유도하도록 설계된 학생 맞춤형 AI 보조교사 시스템 개발 연구가 필요하다. 구체적으로 학년별, 성적별, 그리고 학습 기기 유형별로 학생들에게 맞춤형 피드백을 제공할 수 있는 AI 보조교사 시스템을 개발하는 연구가 진행될 필요가 있다. 둘째, 학습 환경 최적화 관련 연구가 필요하다. 태블릿과 같은 디지털 기기의 사용이 학생들의 집중도와 질문 유형에 영향을 미칠 수 있으므로, 학습에 적합한 환경을 조성하는 것이 중요하다. 이러한 영향에 대한 후속 연구를 통해 학생들의 학습 참여도를 높이는 전략을 제시할 필요가 있다.

이상의 내용을 바탕으로, 향후 후속 연구가 진행됨에 따라 AI 보조교사가 교육 현장에 적절하게 도입될 수 있는 방향을 제시할 수 있을 것이다. 이러한 연구는 개별 학생에 맞춘 맞춤형 피드백과 질문 유도 전략을 통해 학습 성과를 높이고, 교육 현장에서의 AI 보조교사의 효과적인 도입과 활용에 기여할 것으로 기대된다.

Acknowledgments

본 논문은 2024년 한국연구재단의 지원을 받아 수행된 연구임(NRF-2023S1A5A8079184)

References

-

King, A. (1989). Effects of self-questioning training on college students’ comprehension of lectures. Contemporary Educational Psychology, 14(4), 366-381.

[https://doi.org/10.1016/0361-476X(89)90022-2]

-

Rosenshine, B., Meister, C., & Chapman, S. (1996). Teaching students to generate questions: A review of the intervention studies. Review of educational research, 66(2), 181-221.

[https://doi.org/10.3102/00346543066002181]

-

Good, T. L., Slavings, R. L., Harel, K. H., & Emerson, H. (1987). Student passivity: A study of question asking in K-12 classrooms. Sociology of Education, 60(3), 181-199.

[https://doi.org/10.2307/2112275]

-

Chin, C., & Brown, D. E. (2002). Student-generated questions: A meaningful aspect of learning in science. International Journal of Science Education, 24(5), 521-549.

[https://doi.org/10.1080/09500690110095249]

-

Qadir, J. (2023). Engineering education in the era of ChatGPT: Promise and pitfalls of generative AI for education. In 2023 IEEE Global Engineering Education Conference (EDUCON), Vienna, Austria, 1-9. IEEE.

[https://doi.org/10.1109/EDUCON54358.2023.10125121]

-

van den Berg, G., & du Plessis, E. (2023). ChatGPT and generative AI: Possibilities for its contribution to lesson planning, critical thinking and openness in teacher education. Education Sciences, 13(10), 998.

[https://doi.org/10.3390/educsci13100998]

-

Matthew, U. O., Bakare, K. M., Ebong, G. N., Ndukwu, C. C., & Nwanakwaugwu, A. C. (2023). Generative Artificial Intelligence (AI) Educational Pedagogy Development: Conversational AI with User-Centric ChatGPT4. Journal of Trends in Computer Science and Smart Technology, 5(4), 401-418.

[https://doi.org/10.36548/jtcsst.2023.4.003]

-

Al-Smadi, M. (2023). ChatGPT and Beyond: The Generative AI Revolution in Education. arXiv preprint arXiv:2311.15198, .

[https://doi.org/10.48550/arXiv.2311.15198]

-

Baidoo-Anu, D., & Ansah, L. O. (2023). Education in the era of generative artificial intelligence (AI): Understanding the potential benefits of ChatGPT in promoting teaching and learning. Journal of AI, 7(1), 52-62.

[https://doi.org/10.61969/jai.1337500]

-

Santos, R. P. D. (2023). Enhancing chemistry learning with ChatGPT and Bing Chat as agents to think with: a comparative case study. arXiv preprint arXiv:2305.11890, .

[https://doi.org/10.48550/arXiv.2305.11890]

-

Jauhiainen, J. S., & Guerra, A. G. (2023). Generative AI and ChatGPT in school children’s education: Evidence from a school lesson. Sustainability, 15(18), 14025.

[https://doi.org/10.3390/su151814025]

- Yang, M. (2002). Exploring the Characteristics of Students‘ Questioning in Class and Their Educational Implications. Korean Jouranl of Educational Research, 40(1), 99-128.

- Hwang, C., & Lim, H. (2011). An Analysis Study on Students’ Questioning Behaviors Process and Hinderance Factors in University Class. Asian Journal of Education, 12(3), 55-74.

- Lee, J. (2009). A study of self-questioning according to the types of problem. Kookmin Social Science Reviews, 48(2), 75-105.

-

Van der Meij, H. (1988). Constraints on question asking in classrooms. Journal of Educational Psychology, 80(3), 401-405.

[https://doi.org/10.1037/0022-0663.80.3.401]

- Choe, S., Kim, U., & Kim. G. (2003). Maum as the Basis of Trust and Distrust in interpersonal Relationships from Indigenous and Cultural Perspectives. Korean Journal of Culture and Social Issu, 9(2), 1-17.

-

Dillon, J. T. (1982). The multidisciplinary study of questioning. Journal of Educational Psychology, 74(2), 147-165.

[https://doi.org/10.1037/0022-0663.74.2.147]

- Lee, J. (2016). Exploring a Utilization Plan of Student Questions for a Learner-Centered Class. Journal of Learner-Centered Curriculum and Instruction, 16(4), 223-242.

- Kim, M. (2015). The Meaning of “Questioning” in Teaching a Subject in the Classroom. The Journal of Elementary Education, 28(3), 1-19.

- Jeon, S. (2010). Understanding about “Questioning” as the Language of Instruction. The Korean Journal of Philosophy of Education, 50, 165-187.

- Kim, S., Yeo, S., & Woo, K. (1999). A Study on Students Questioning Activity in Science Classes ( II ) - Analysis of the Patterns of Students’ Questions -. Journal of the Korean Association for Science Education, 19(4), 560-569.

- Choi, S., & Yeo, S. (2011). Analysis of elementary students’ question types in their science class. The Bulletin of Science Education, 24(1), 137-146.

- James, I., & Carter, T. S. (2007). Questioning and Informational Texts: Scaffolding Students Comprehension of Content Areas. Forum on Public Policy Online, 2007(3), n3. Oxford Round Table.

-

Dillon, J. T. (1988). The remedial status of student questioning. Journal of Curriculum studies, 20(3), 197-210.

[https://doi.org/10.1080/0022027880200301]

-

Seong, G. (2020). Effects of Student-Generated Questions on University Students’ Self-Directed Learning, Academic Self-Efficacy, and Self Concept. Journal of Learner-Centered Curriculum and Instructi, 20(6), 1425-1454.

[https://doi.org/10.22251/jlcci.2020.20.6.1425]

- Hwang, C. (2010). Analysis study on students’ questioning behaviors and hindrance factors in university class [Doctoral dissertation], Yonsei University.

-

Taboada, A., & Guthrie, J. T. (2006). Contributions of student questioning and prior knowledge to construction of knowledge from reading information text. Journal of literacy research, 38(1), 1-35.

[https://doi.org/10.1207/s15548430jlr3801_1]

- Chung, Y., & Bae, J. (2002). The Effects of Science Question Enhancement Instruction on the Science Question Level and Achievement of Middle School Students. Journal of the Korean Association for Science Education, 22(4), 872-881.

- Lee, J. (2017). A study on evaluation of reading by application of student-generated questions [Master’s thesis], Gyeongin National University of Education, Incheon, Korea.

-

Scardamalia, M., & Bereiter, C. (1992). Text-based and knowledge based questioning by children. Cognition and instruction, 9(3), 177-199.

[https://doi.org/10.1207/s1532690xci0903_1]

-

Pizzini, E. L., Shepardson, D. P., & Abell, S. K. (1991). The inquiry level of junior high activities: Implications to science teaching. Journal of research in science teaching, 28(2), 111-121.

[https://doi.org/10.1002/tea.3660280203]

- White, R.T., & Gunstone, R.F. (1992). Probing understanding. London: Falmer Press

· 2008년 서울교육대학교 초등교육과(학사)

· 2013년 서울교육대학교 컴퓨터교육전공(교육학석사)

· 2018년 서울교육대학교 컴퓨터교육전공(교육학박사)

· 2022년 ~ 현재 대구교육대학교 컴퓨터교육과 조교수

관심분야 : 인공지능 교육, 교육 데이터 분석, 디지털 리터러시

yhlee@dnue.ac.kr