AI 통합교육의 인공지능 윤리역량 평가도구 개발 방향 탐색

초록

본 연구는 AI 기술의 급속한 발전과 교육현장 도입 확대에 따라 초‧중등 AI 통합교육 현장에서 학습자의 인공지능 윤리역량을 효과적으로 평가하기 위한 도구 개발 방향을 탐색하고자 진행되었다. 이를 위해 컴퓨터교육 전문가 및 현장교사 7인을 대상으로 포커스 그룹 인터뷰를 실시하고, 시나리오 기반 평가(SBA)와 경험학습 기반 평가(ELBA)를 중심으로 평가도구의 적절성과 개선점을 분석하였다. 연구 결과, AI 윤리역량 평가도구는 (1) AI 윤리 개념과 하위 요소를 명확히 구분하여 체계화할 것, (2) 실제성을 강조한 시나리오 및 실제 데이터를 활용하여 학습자에게 문제해결 경험을 제공할 것, (3) 선택형, 서술형, 프로젝트 기반 등 다양한 평가 방식을 통합적으로 활용, (4) 학교급과 학생 발달 수준에 맞는 차별화된 평가 항목과 난이도를 제시할 것 등이 중요하다는 의견이 도출되었다. 또한 평가 결과를 바탕으로 학습자의 윤리적 성장을 지원하기 위해 루브릭 및 피드백 제공 방식의 구체적 설계가 필요하다는 것을 확인하였다. 본 연구는 AI 통합교육에서 인공지능 윤리역량을 종합적으로 진단하고 함양하기 위한 평가체계 구축에 기초 자료를 제공하였으며, 향후 실제 수업 적용 및 효과성 검증 연구를 통해 더욱 정교한 평가도구 개발이 가능할 것으로 기대한다.

Abstract

This study aimed to explore directions for developing assessment tools to effectively measure learners' AI ethicscom-petency in elementary and secondary AI-integrated education, in response to the rapid development of AI technologyand its expanding integration into educational settings. To this end, a focus group interview was conducted with sevencomputer education experts and in-service teachers to analyze the appropriateness and improvements of assessment tools, focusing particularly on scenario-based assessment (SBA) and experience-learning-based assessment(ELBA). As a result, participants emphasized the importance of (1)clearly defining and systematizing AI ethics concepts and their sub-elements, (2)providing learners with authentic problemsolving experiences through realistic scenarios and actual data, (3)integrating various assessment methods, such as multiple-choice, essay-type, and projectbased tasks, and (4)differentiating assessment items and difficulty according to learners' grade levels and developmental stages. Additionally, it was confirmed that detailed rubric design and feedback mechanisms are necessary to support learners' ethical growth based on the assessment outcomes. This study provides foundational data for constructing an assessment framework that comprehensively diagnoses and fosters AI ethics competency in AI-integrated education. Future research involving practical classroom implementation and effectiveness verification is expected to further refine these assessment tools.

Keywords:

AI-Integrated Education, AI Ethics Competency, Development of Assessment Tools, Scenario-Based Assessment (SBA), Experience Learning-Based Assessment (ELBA)키워드:

AI 통합교육, 인공지능 윤리역량, 평가도구 개발, 시나리오 기반 평가(SBA), 경험학습 기반 평가(ELBA)1. 서론

인공지능 기술의 급속한 발전과 교육현장 도입 확대는 교육 환경과 학습 방식의 근본적인 변화를 가져오고 있다[1, 2]. 특히 ChatGPT와 같은 생성형 AI의 등장은 교육현장에새로운 가능성과 함께 복합적인 윤리적 도전을 제시하고 있다. 이러한 상황에서 AI 윤리교육의 중요성이 증대되고 있으며, 초·중등 교육과정에서 AI 윤리 역량 함양의 필요성이강조되고 있다.

AI 통합교육은 인공지능을 이용한 문제해결 과정에서 인공지능 기술 교육과 인공지능 윤리 교육이 유기적으로 결합되어 함께 이루어지도록 제안하는 교육 모델을 의미한다[3]. 이는 단순히 AI 기술을 가르치거나 윤리적 이슈를 별도로 다루는 분절적 접근이 아닌 기술의 이해와 윤리적 판단이 통합된 형태의 교육을 지향한다.

AI 윤리 문제에 대한 실제적 해결능력과 윤리적 판단력을 측정하고, 이를 통해 학습자의 장기적 역량 발달을 지원할 수 있는 실천적 평가 도구가 필요하다. 그러나 기존의 AI 윤리 평가 도구들은 이론과 실천의 연계, 기술과 윤리의 통합적 접근 측면에서 한계를 보여왔다. 첫째, 기존의 일반적인 윤리교육 평가 방식은 지식 전달 중심의 추상적 이론 평가에 치중하여 AI 기술의 특수성과 복잡성을 반영하지 못하고 있다. 김태창과 변순용(2021)의 연구에서는 AI 윤리의 필요성과 교육 내용을 제시했으나, 실제 교육 현장에서의 평가 방안은 구체화되지 않았다[4]. 둘째, 이론적 지식과 실천적 역량을 통합적으로 평가할 수 있는 체계가 부재하다. 배진아(2022)의 연구는 중등학생 대상 AI 윤리역량 평가척도를 개발하였으나 이는 자기보고식 설문에 기반한 것으로 실제 문제해결 상황에서의 윤리적 판단과 행동을 평가하는 데 한계가 있다[5]. 정다이, 박형빈(2023)의 연구에서는 초등학교AI 윤리교육 프로그램을 개발 및 적용하고 효과성을 검증하였으나, 역시 사전사후검사를 자기보고식으로 실시하여 실제 윤리적 상황에서의 판단력과 실천력을 객관적으로 측정하는 데 제한이 있었다.[6] 셋째, 실제 AI 기술 활용 맥락에서의 윤리적 판단을 요구하는 평가 도구가 부족하다. 시나리오 기반의 평가가 일부 시도되고 있으나 대부분 인공지능 기술의 실습과 분리된 형태로 제시되어 AI 통합교육의 취지를살리지 못하는 실정이다[7, 8].

본 연구는 이러한 한계를 극복하고자 두 가지 측면에서 차별화된 접근을 시도한다. 첫째, AI 기술 교육과 윤리 교육의 통합적 관점에서 평가 체계를 구축한다. 기존 연구들이 AI 기술과 윤리를 분절적으로 다루었다면, 본 연구는 AI 문제해결 과정 전반에 걸쳐 윤리적 판단이 통합된 형태의 평가 모델을 제안한다. 둘째, 지식 중심의 평가를 넘어 실천적 역량을 측정할 수 있는 이원적 평가 도구를 개발한다. 시나리오 기반 평가(SBA)와 경험학습 기반 평가(ELBA)를 결합하여 학습자의 윤리적 인식, 판단, 실천 능력을 종합적으로 평가하는 체계를 구축한다.

이에 본 연구는 AI 통합교육의 확대에 따라 교육현장에서 실행 가능하면서도 객관적이고 신뢰성 있는 표준화된 AI 윤리 역량 평가 체계의 개발 방향을 탐색하고자 한다. 특히 포커스 그룹 인터뷰를 통해 시나리오 기반 평가와 경험학습 기반 평가의 적절성과 개선점을 분석함으로써 향후 AI 통합교육에서 활용할 수 있는 실효성 있는 평가 도구 개발의 기초를 마련하고자 한다.

2. AI 통합교육

2.1 AI 통합교육 모델

AI 통합교육 모델은 기존의 분절적 접근에서 벗어나 기술과 윤리의 통합적 학습을 지향한다. AI 통합 교육모델은 다음의 목표 달성을 위해 설계하였다. 첫째, 기존의 지식 전달 중심의 인공지능 윤리교육에서 벗어나 인공지능 기술을 이용한 문제해결 과정에서 윤리적 문제를 고려하고, 인공지능 윤리를 실천할 수 있는 역량 향상을 위해 인공지능 교육과 인공지능 윤리교육을 통합하였다. 둘째, 컴퓨팅 사고력 함양 및 인공지능 역량 함양을 교육 목표로 하였다. 셋째, 학습자의 인공지능 학습효과를 극대화하기 위해 다양한 교수학습방법을 제시하였다. 넷째, AI 통합 역량을 기를 수 있는 평가 모델을 제시하였다. AI 통합 역량은 컴퓨팅 사고력, 인공지능 소양, 인공지능 윤리역량을 포함하고 있다[9].

본 연구는 AI 통합교육 모델에서 인공지능 윤리역량을 효과적으로 평가하는 방안에 관한 탐색적 연구이다. AI 윤리역량 평가는 일반적인 교과 평가와는 달리 정답이 정해져 있지 않은 복잡한 문제가 대부분이고, 학습자의 윤리역량 결과를 점수화하여 평가기준으로 활용하기에 어려움이 있다. 이러한 한계와 문제점을 최소화 하기 위해 국내외의 다양한 윤리 역량 평가 방법과 척도를 분석하였으며, 이를 바탕으로 교육 현장에 적용 가능한 평가 모델을 개발하였다.

기존의 AI 윤리역량 평가는 시나리오나 딜레마 기반의 접근이 주를 이루었으며, AI 기술을 배우는 과정에서 기술 이해와 윤리적 상황판단을 함께 평가하는 연구는 시도된 바가 없다. AI 윤리 교육에서는 학습자가 구체적이며 친숙한 상황에서 자신이 배운 윤리적 지식을 바탕으로 판단하고, 이러한 판단을 실제 행동에 적용하는 것이 중요한다. 김태창 외(2021)에서는 AI 윤리역량이 교육을 진행하는 과정 또는 학습 맥락 안에서 평가되고 피드백이 제공될 때 함양될 수 있다고 강조하고 있다[4]. 따라서, AI 통합교육 평가모델과 같이 기술 실습과 윤리적 판단이 유기적으로 연계된 평가 체계 구축이 필요하다.

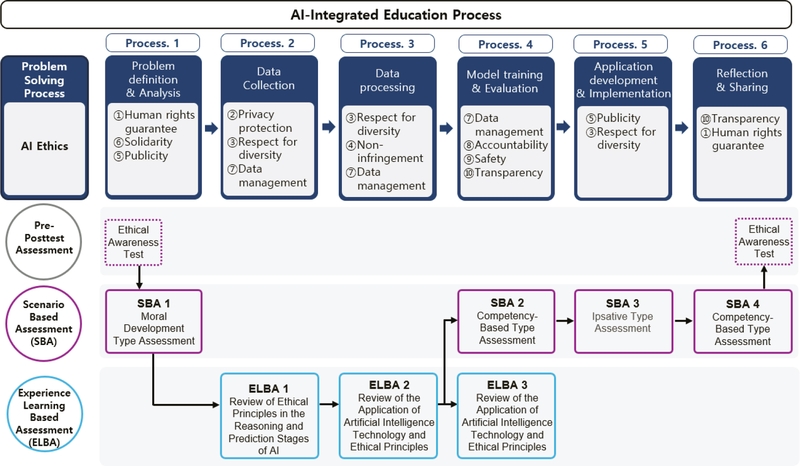

Fig. 1의 ‘AI 통합교육 평가모델’은 기존의 AI 통합교육 모델에서 평가를 중심으로 재구성한 것이다[10]. AI 통합교육 모델에서 제시하고 있는 인공지능을 이용한 문제해결 프로세스 6단계를 기본으로 하고, 각 단계마다 인공지능 윤리 원칙을 포함하고 있다. 단계에 따라 사전‧사후검사, 시나리오 기반 평가, 경험학습 기반 평가가 진행될 수 있도록 구조화하였다. 사전‧사후의 자기보고식 평가는 배진아 외(2022)가 개발한 중등대상 인공지능 윤리역량 평가척도를 적용하고 있다[5]. 본 연구에서는 실제 사례나 상황을 반영한 ‘시나리오 기반 평가(SBA, Scenario Based Assessment)’와 인공지능의 실제 학습 과정을 반영한 실습 중심의 ‘경험학습 기반 평가(ELBA, Experience Learning Based Assessment)’ 유형을 개발하였고 포커스 그룹 인터뷰를 통해 평가 도구 개발 방향을 탐색하고자 한다. 시나리오 기반 평가와 경험학습 기반 평가의 이원적 평가 체계를 통해 인공지능 윤리에 대한 이론적 이해와 실천적 역량을 균형있게 평가하고 학습자의 종합적 윤리역량 향상을 도울 수 있다.

2.2 시나리오 기반 평가

시나리오 기반 평가(SBA)는 현재 또는 미래에 발생할 가능성이 높은 가설적 시나리오를 제시한다. 실행 가능한 선택지를 통해 학습자의 윤리적 판단과 실천 의지를 평가하는 것으로 윤리적 감수성과 비판적 사고를 촉진하고 학습자의 가치 및 태도를 평가할 수 있는 장점이 있다. 시나리오 기반 평가는 도덕적 발달 유형평가, 역량기반 평가, 입서티브 유형 평가 3가지로 개발하였다[10]. Fig. 1에서 SBA 1은 도덕적 발달단계를 적용한 선택지를 제공하고, SBA 2와 SBA 4는 지식, 기능, 태도의 역량 기반 선택지를 제공한다. SBA 3은 윤리원칙 선호 순위에 기반한 선택지를 제공한다. AI 통합교육 프로세스에 가장 적합한 평가 유형을 기본으로 설계하였으나, SBA 1 ~ SBA 4는 학생들의 수준이나 학교 환경 등 상황에 따라 선택적으로 사용 가능하다.

공통으로 제시하는 시나리오를 바탕으로 도덕적발달 유형 평가, 역량기반 평가, 입서티브 유형 평가의 응답 문항을 달리 하고 있으며, 유형별 평가 문항은 부록의 <표1~7>으로 제공하였다.

도덕적 발달 유형 평가는 콜버그의 도덕적 발달 단계를 적용한 AI 윤리역량 평가방법이다[11]. 중등학생에서 일반적으로 관찰되는 도적적 추론 단계에 맞춰 전인습적 수준의 2단계, 인습적 수준의 3-4단계, 후인습적 수준의 5단계와 연결된 행동대안을 개발하였다. 이 평가의 목적은 도덕적 발달 단계와 연계된 선택지를 제공함으로써 개별 학습자의 윤리적 추론 단계를 예측하는데 있다. 평가 결과를 바탕으로 학습자의 윤리적 판단능력과 성숙도에 대해 이해함과 동시에 이를 바탕으로 보다 고차원적인 윤리역량 함양을 지원할 수 있다.

역량 기반 평가는 지식(Knowledge), 기능(Skill), 태도(Attitude)의 척도를 적용한 AI 윤리역량 평가방법이다[12]. 지식은 시나리오에 내포되어 있는 인공지능 윤리원칙에 대한 학습자의 이해 여부를 확인하다. 태도는 딜레마적인 윤리적 상황에서 발현되는 개인의 가치관이나 신념, 판단에 대한 문항이다. 기능은 문제를 해결하기 위해 학습자가 선택할 행동에 관한 것이다. 이는 학생들이 인공지능을 둘러싼 주요 논쟁에 대해 이론적 지식뿐만 아니라 학습자의 비판적 사고 및 의사결정 능력, 실제 상황에서의 문제해결능력을 평가할 수 있다.

입서티브 유형 평가는 입서티브(ipsative) 응답 형식을 적용한 AI 윤리역량 평가방법이다[13]. 학습자가 해당 시나리오 상황에 처했을 때를 가정하고 자신이 가장 할 것 같은 행동과 가장 하지 않을 것 같은 행동 두 가지를 선택한다. 2개 이상의 문항집합을 주고 선호순위를 정하게 하거나 선호 또는 비선호 문항을 선택하게 하는 형식이다. 이러한 방식은 자기인식에 중점을 두고 자신과 부합하는 항목을 선택하게 되어 있어 응답 왜곡이 덜하다는 장점이 있다. 측정된 결과는 다른 사람과의 비교가 아닌 학생 개개인별로 다른 평가 항목과 비교하여 윤리적 역량이 높고 낮음을 파악하는데 유용하다.

2.3 경험학습 기반 평가

경험학습 기반 평가(ELBA)는 Fig. 1의 인공지능을 이용한 6단계의 문제해결 과정 중에서 데이터 수집(Process. 2), 데이터 전처리(Process. 3), 모델 학습 및 검증(Process. 4)에 적용된다. 실제 인공지능 개발 과정에서의 윤리적 사항을 직접 경험하고 평가하는 것으로 데이터 편향, 프라이버시 보호, 다양성 존중 등 인공지능 윤리의 실제적 적용을 체험하고 평가할 수 있는 기회를 제공할 수 있다. 프로세스에 따른 실습 및 평가 내용은 부록으로 제공하였다.

3. 연구방법

3.1 포커스 그룹 인터뷰 대상자

포커스 그룹 인터뷰(Focus Group Interview)는 연구 주제에 관한 심층적 데이터를 짧은 시간 내에 수집하기 위해 전문가 집단의 상호작용적 담화를 활용하는 질적 연구방법이다. 이 방법론에서는 연구 목적에 부합하는 전문성과 경험을 보유한 참여자 선정이 연구의 타당성 확보에 핵심적 요소로 작용한다. Krueger와 Casey(2014)는 참여자들 간의 동질적 특성이 집단의 응집력을 향상시키고 토의의 활성화를 촉진하여 심층적인 질적 데이터 도출에 기여한다고 제시하였다[14]. 또한 참여자 구성의 양적 측면에서는 김성재 외(2010)가 효과적인 그룹 상호작용을 위한 최적의 표본 크기로 5~10명을 권장하였다[15]. 이에 본 연구에서는 참여자들 간 전문적 담화와 활발한 상호작용을 위해 컴퓨터 및 컴퓨터 교육 전문가 4인, 인공지능 교육 전문가 1인, 현장전문가 2인, 총 7인을 포커스 그룹 인터뷰 대상으로 하였다.

포커스 그룹 인터뷰 대상자는 전문 영역별로 다음과 같이 구성되었다. 첫째, 컴퓨터 및 컴퓨터교육 전문가는 컴퓨터 또는 컴퓨터 교육 분야 박사학위 소지자로서 대학교수및 강사로 재직 중이며, 5년 이상의 현장경력과 함께 AI 윤리 및 중등 교육 관련 연구·교육·평가 경험을 보유한 4인으로 구성하였다. 둘째, 인공지능 교육 전문가는 지능로봇 전공 박사학위를 소지한 교수로서 AI 분야 15년 이상의 연구 경력과 8년 이상의 현장교육 경험을 갖추었으며, AI 윤리 및 교육평가도구 개발·자문 경험이 있는 1인을 선정하였다. 셋째, AI 교육 현장전문가는 AI 분야의 연구 및 현장교육, 교육평가 경험이 있는 중등교사 2인으로 구성하였다. 첫 번째 참여자는 윤리 교과를 담당하는 중학교 교사로서 현재 인공지능융합교육 석사과정에 재학 중이며 5년 이상의 교육현장 경력을 보유하고 있다. 두 번째 참여자는 정보 교과를 담당하는 고등학교 교사로서 인공지능융합교육 석사학위 소지자로 7년 이상의 현장 교육 경험을 갖추고 있다.

3.2 포커스 그룹 인터뷰지

포커스 그룹 인터뷰지는 Krueger와 Casey(2014)가 제안한 질문 구조와 토론 가이드에 기반하여 반구조화된 다섯 단계 질문 유형에 따라 설계되었다. 첫째, 도입 질문은 참여자들의 자기소개와 인공지능 교육 및 평가 경험 공유를 통해 라포를 형성하고 토론을 위한 편안한 분위기를 조성하는 데 중점을 두었다. 둘째, 소개 질문은 학교교육 현장에서의 인공지능 교육 및 AI 윤리 교육에 관한 전반적 인식과 AI 윤리역량 평가 시 직면하는 어려움을 탐색하는 개방형 질문으로 구성하였다. 셋째, 전환 질문은 시나리오 및 경험학습 기반 AI 윤리역량 평가도구 개발의 필요성과 기대효과에 관한 의견을 수렴하는 데 초점을 맞추었다. 넷째, 핵심 질문은 평가도구 개발의 방향성, 평가항목 구성, 평가문항의 변별성, 평가적용 방법, 평가문항 설계 시 고려사항 등 연구의 중심 주제에 관한 5개 내외의 심층적 질문으로 구성하였다. 마지막 종결 질문은 토론 내용의 요약과 그에 대한 적절성 확인 및 추가 의견 수렴을 위한 질문으로 마무리하였다.

포커스 그룹 인터뷰지는 내용 타당도 확보를 위해 3인의 전문가(교수 또는 박사학위 소지자)를 통한 검증 과정을 거쳤으며, 검증 결과에 기반하여 수정·보완 작업이 이루어졌다. 포커스 그룹 인터뷰는 단일 회기로 진행되었으며, 포커스 그룹 인터뷰 질문 내용은 Table 1과 같다.

3.3 연구절차

포커스 그룹 인터뷰는 2025년 2월에 실시하였으며, 사전 준비, 목적 소개, 인터뷰 실시의 세 단계로 진행하였다. 사전 준비 단계에서는 인터뷰의 효율성과 참여자들의 사전 이해를 증진하기 위해 인터뷰지를 사전에 전달하였으며, 평가도구의 적절성 평가를 위한 리커트 척도 설문지를 함께 제공하였다. 목적 소개 단계에서는 연구의 목적을 명료하게 설명하고 연구 윤리지침에 따라 참여자들로부터 서면 동의서를 작성하였다. 인터뷰 실시 단계에서는 반구조화된 면담방법을 활용하여 인터뷰를 진행하였으며, 연구자는 현장노트를 통해 주요 발언과 비언어적인 상호작용을 기록하였다. 인터뷰 종료 후에는 녹취된 자료를 전사하여 질적 자료 분석 절차에 따라 핵심 개념과 주제를 도출하였다.

3.4 자료분석

포커스 그룹 인터뷰에서 수집된 녹화자료, 전사자료, 현장노트를 바탕으로 Glaster와 Strauss(2017)의 근거이론에 따른 개방코딩과 지속적 비교 분석 방법을 진행하였다[16, 17]. 개방코딩 단계에서는 전사 자료를 반복적으로 읽으면서 연구결과에 중요한 부분을 세그멘팅하고 코드에 라벨링을 한 후 주제별로 자료를 범주화 하였다. 범주화 단계에서는 개방코딩을 통해 분류한 자료들을 상위범주로 분류하고 명명했다. 이 과정에서 자료들 간의 비슷한 점과 다른 점을 발견하며 지속적인 비교를 통해 상위범주를 구성했으며, 범주 명명 시 연구 목적과의 관련성, 범주간의 유사성, 상호 배타성을 고려했다. 범주 확인 단계에서는 도출된 평가도구가 적절하게 구성되었는지 전사 자료와의 지속적 비교를 통해 검토했다. 추가적으로 리커트 척도의 설문을 통해 평가도구의 적절성을 확인했다.

자료분석의 신뢰도와 타당도를 확보하기 위해 삼각측정법, 구성원 점검, 동료 검토를 통한 교차 확인을 실시했다[18, 19]. 삼각측정을 위해 녹화자료, 전사자료, 현장노트 등 다양한 자료를 분석에 활용하였다. 구성원 점검에서는 분석결과에 대해 의문점이나 논의가 발생할 경우 전화, 이메일을 통해 추가 질문을 실시하여 참여자 의견을 반영하였다. 마지막 동료 검토 단계에서는 내용타당도 전문가 3인(교수 또는 박사학위 소지자 3인)을 대상으로 내용타당도를 검토했으며, 의견 불일치 시 반복적인 의견 진술과 조정을 통해 재분류하고 재조직하였다.

4. 연구결과

4.1 정량적 분석 결과

포커스 그룹 인터뷰(FGI)를 실시하기에 앞서 평가도구의 적절성에 대한 사전 평가를 진행하였다. 포커스 그룹 인터뷰 참여자들에게 인터뷰지와 함께 평가도구의 적절성을 평가하기 위한 리커트 척도 설문지를 제공하였으며, 이를 통해 수집된 정량적 데이터를 분석하였다. 평가는 리커트 척도(5점)를 사용하여 도덕적 발달 유형 평가, 역량기반 유형 평가, 입서티브 유형 평가, 경험학습 기반 평가의 네 가지 범주에 대해 진행되었다. 각 범주별 평가 결과는 다음과 같다.

1) 도덕적 발달 유형 평가

도덕적 발달 유형 평가는 콜버그의 도덕발달이론을 적용한 평가방법으로 Table 2와 같이 전문가 설문 결과 모든 항목에서 평균 4.29 이상의 높은 점수를 받았다.특히 ‘단계 설정의 적절성’ 항목은 평균 4.43으로 가장 높게 평가되었으며, 모든 전문가가 긍정적으로 응답하였다. 표준편차는 ‘도덕 발달 단계 적용 타당성’이 0.76으로 가장 높았으나, 전반적으로 전문가들의 의견이 일치하는 경향을 보였다.

2) 역량기반 유형 평가

역량기반 유형 평가는 지식(Knowledge), 기능(Skill), 태도(Attitude)의 관점에서 AI 윤리역량을 평가하는 방법이다. Table 3과 같이 전문가 설문 결과 ‘영역 구성 타당성’이 평균 4.57로 가장 높은 점수를 받았으며, ‘문항 변별성’이 평균 4.00으로 상대적으로 낮게 평가되었다. 표준편차는 ‘영역 구성 타당성’과 ‘선택지 적절성’이 0.79로 다소 높게 나타났으나, 6명의 전문가가 해당 항목에 대해 긍정적으로 응답하였다.

3) 입서티브 유형 평가

입서티브 유형 평가는 윤리원칙의 포함여부와 선호도 측면에서 AI 윤리역량을 측정하는 평가방법이다. Table 4와 같이 입서티브 유형 평가에서는 ‘응답방식(윤리원칙의 포함여부)의 적절성’과 ‘응답방식(선호도) 적절성’이 모두 평균 4.43으로 높게 평가되었다.

다른 평가방법들과 비교했을 때 입서티브 유형 평가는 상대적으로 표준편차가 높게 나타났으나, 대부분의 항목에서 긍정의 응답을 보였다.

경험학습 기반 평가는 AI 통합교육의 문제해결과정에서 실습을 통해 윤리 문제를 확인・검토하는 평가방법으로 가장 많은 평가항목을 포함하고 있다. Table 5와 같이 전문가 설문 결과 ‘방법의 적절성’이 평균 4.71로 전체 평가항목중 가장 높게 평가되었다. ‘구조의 적절성’, ‘난이도 적합성’, ‘평가의 타당성’도 평균 4.57로 높은 점수를 받았다.

포커스 그룹 인터뷰에 앞서 실시된 사전 평가 결과 본 연구에서 제안한 AI 윤리역량 평가도구는 전반적으로 전문가들의 높은 평가를 받은 것으로 나타났다. 평가 범주별로 살펴보면, 경험학습 기반 평가가 방법론적 측면에서 가장 높은 평가를 받았으며, ‘구조의 적절성’, ‘난이도 적합성’, ‘평가의 타당성’ 항목에서도 높은 점수를 받았다. 도덕적 발달 유형 평가는 모든 항목에서 일관되게 높은 점수를 받았으며, 역량기반 유형 평가는 ‘영역 구성 타당성’에서 특히 높은 평가를 받았다. 입서티브 유형 평가는 다른 평가 범주에 비해 상대적으로 표준편차가 높게 나타나 전문가들 간의 의견 차이가 있었으나, 전반적으로 긍정적인 평가를 받았다.

이러한 정량적 분석 결과는 포커스 그룹 인터뷰를 통한 정성적 분석을 위한 기초 자료로 활용되었으며, 이후 진행된 포커스 그룹 인터뷰에서는 평가도구의 개발 방향과 구체적인 개선점에 대한 심층적인 논의가 이루어졌다.

4.2 정성적 분석 결과

전문가들은 AI 윤리 역량을 종합적으로 평가하기 위해서는 AI 윤리에 대한 개념 및 하위 요소에 대한 구성이 보다 구체적으로 제시될 필요가 있음을 강조했다. 특히 현재학생들이 실제로 접하고 있는 생성형 AI와 같은 기술에대한 고려가 평가도구에 반영되어야 한다는 의견이 제시되었다. 따라서 AI 통합교육에서의 AI 윤리 역량을 AI 윤리원칙, 이슈에 대한 지식 측면, AI 윤리 이슈 분석 및 대응의 기능 측면, AI 윤리에 대한 가치관 및 책임감과 같은태도의 측면, 실제 AI사용 및 개발 시 발현되는 윤리적 행동측면 등 AI 윤리 역량을 학습자에 맞게 정의하고 체계화할 필요가 있다.

“AI 윤리 역량을 종합적으로 평가하기 위해서는 AI 윤리에 대한 개념 및 하위 요소에 대한 구성이 보다 구체적으로 제시될 필요가 있어 보입니다. 또한 생성형 AI와 같은 학생들이 직접 접할 수 있는 AI 기술에 대한 부분도 고려해야 할 것으로 보입니다.” (전문가 A)

“윤리역량을 평가할 때 평가 결과에 모든 사람이 동의할 수 있는 기준과 근거를 마련하는 것이 가장 중요할 것 같습니다.” (전문가 E)

전문가들은 학생들이 AI 윤리적 문제를 실제 상황에 어떻게 적용할지 이해할 수 있도록 다양하고 구체적인 실사례와 시나리오의 활용이 중요하다고 강조했다. 특히 인위적으로 오류를 만든 데이터보다 실제 문제점이 있는 데이터를 활용하여 학습하고, 이후 학생들이 실생활 데이터를 수집하여 응용할 수 있는 기회를 제공하는 것이 효과적이라고 제안하였다. 또한 경험학습 기반 평가가 가지는 교육적 가치는 인정하면서도, 현실적인 수업 여건 속에서 효과적으로 활용할 수 있는 방안이 마련되어야 한다는 의견이 제시되었다.

“학생들이 AI 윤리적 문제를 실제 상황에 어떻게 적용할지 이해할 수 있도록 돕기 위해, 다양하고 구체적인 실사례와 시나리오를 통해 평가할 필요가 있습니다.” (전문가 B)

“경험학습기반 평가의 각 단계마다 예측되는 상황에 대한 구체적인 예시와 사례가 제시되어야 합니다. 예를 들어, 제공된 데이터의 문제점 발견에서 학생들이 발견할 문제 상황의 예시 등이 포함되어야 합니다.이러한 구체적인 사례 없이는 교사들이 현장에서 효과적으로 적용하기 어렵습니다.” (전문가 F)

“경험학습기반 평가의 내용은 학생들에게 이상적인 AI 윤리 교육 방법이라고 생각합니다. 이 수업을 진행하기 위한 윤리적 문제점이 반영된 실습 데이터가 다양하게 실제 데이터로 제시되어야 합니다. 억지로 오류가 만들어져 있는 데이터보다, 실제 문제점이 있는 데이터로 학습하여 활동 이후 학생들이 실생활 데이터를 수집하여 응용할 수 있도록 제시되면 좋을 것 같습니다.” (전문가 E)

전문가들은 AI 윤리 역량 평가도구 개발에 있어 ‘실제성’ 을 핵심으로 하고 있다[20]. 이는 단순히 이론적 지식을 측정하는 것을 넘어 실제 AI 윤리 문제 상황에서의 판단과 행동 역량을 평가해야 한다는 방향성을 시사한다. 이를 위해서는 인위적으로 만들어진 가상 시나리오, 인위적 오류를 삽입한 데이터셋보다는 실제 AI 시스템에서 발생했거나 발생할 수 있는 윤리적 딜레마 상황을 활용이 필요하다.이러한 접근이 AI 윤리 문제의 복잡성을 경험하고 학생들의 문제해결능력과 윤리적 감수성을 향상시킬 수 있다.

특히 경험학습기반 평가는 안내된 교수(guided instruction)를 통한 진행이 요구된다[21]. 단순히 윤리적 문제를 찾아보라고 지시하는 것은 학생들이 방향을 잡지 못하거나 표면적인 문제만 발견할 수 있다. 교수자와 학생이 함께 평가단계에서 발견가능한 윤리적 이슈와 접근법에대해 알아본 후 학생 스스로 문제를 발견하고 해결책을 고민할 시간을 제공할 필요가 있다. 학생들은 기본적인 안내를 받으면서도 스스로 사고하고 발견하는 과정을 통해 컴퓨팅 사고력 및 AI 윤리역량을 함양할 수 있다.

1) 평가 문항의 명확성과 적합성

전문가들은 평가도구를 개발하는 데 있어 시나리오와 평가문항간의 일관성, 명확성, 적합성 확보가 중요하다고 강조했다. 시나리오에 명시되지 않은 가정을 기반으로 하는 선택지는 학생들의 문항 해석이 혼란을 초래할 수 있기 때문이다. 특히 태도를 평가하는 선택지는 지식 측정이 아닌 실제 감정, 가치관, 행동성향을 드러낼 수 있도록 구성할 필요가 있으며, 효과적인 평가를 위해서 명백히 틀린 선택지가 아닌 매력적인 오답 보기가 요구된다.

“도덕적 발달 유형평가에서 평가문항 하나로 도덕적 유형을 구분하기에는 무리가 있을 것 같아 다양한 문항을 구성할 필요성이 있습니다.” (전문가 B)

“역량기반 유형평가의 지식 문항에서 선택지 1번의 내용인 ‘...기록을 무기한으로 저장하는 것은...’은 시나리오에서 제시되지 않은 사항으로 학생들이 오해할 수 있습니다. 즉, 시나리오 상에 무기한 저장한다는 점이 없으므로 해당 선택지를 답이 아닌 것으로 판단할 수 있습니다. 따라서 ‘무기한으로 저장할 수 있으므로...’와 같이 수정하여 오해의 여지를 줄이는 것이 필요합니다. 또한 태도 문항에서 선택지의 내용이 위에서 정의한 태도 역량의 내용보다는 지식에 더 가깝게 보여집니다. 따라서 선택지에 느낌, 성향 등이 드러날 수 있도록 수정하는 것면 태도 역량을 보다 정확하게 평가할 수 있을 것입니다.” (전문가 A)

“역량기반 유형 평가에서 지식 부분은 오답들이 매력적으로 보이는데요. 기능과 태도는 조금 더 오답 매력도가 높은 보기를 한개 정도씩 추가하는 것도 필요해 보입니다.” (전문가 C)

2) 평가 문항 설계 시 고려사항

전문가들은 평가 문항 설계 시 다양한 평가 방식의 필요성을 강조했다. 특히 선택형 문항만으로는 윤리적 태도와 가치관을 평가하는 데 한계가 있다는 점을 지적하고, 서술형 문항이나 사고 과정을 묻는 문항이 필요함을 제안했다.

“현재 문항 구성은 명백한 정·오답 구분을 통해 파악하기에 편리하지만, 윤리적 태도나 가치관에 대한 평가는 단일 정답으로만 가늠하기 어려운 측면이 있습니다. 추가적으로 서술형 문항이나 사고 과정을 묻는 문항을 도입하면더 입체적인 평가가 가능할 것으로 보입니다.” (전문가 D)

“도덕적 발달 유형평가에서 콜버그 이론의 단계에 따라 2-5단계를 선정하고, 각 문항의 선택지가 이론에 맞게 판단 수준 차이가 명확하게 구분은 되나, 이는 AI 윤리적 사고 수준을 참고하는 데는 유용하지만, AI 윤리 평가의 독립적인 기준으로 삼기에는 어려움이 있다고 생각한다. AI 윤리에서는 학생(개발자의 역할)의 도덕적 발달 단계보다 비용적인 문제, 공정성, 개인정보, 편향 등의 구체적인 원칙 이해 여부 파악이 필요할 것으로 보입니다.” (전문가 E)

“AI 윤리에는 기술이 미치는 사회적 영향을 넘어서 경제적 측면도 고려하는 요소를 추가할 필요성이 있음. AI 기술의 발전은 단순히 윤리적 문제에 그치지 않고, 경제적 구조와 시장 환경에 광범위한 영향을 미치며 AI는 고용 시장, 생산성, 소득 불평등 등 경제적 변수에 직접적인 영향을 미칠 수 있기 때문에 함께 고려할 필요성이 있습니다” (전문가 B)

AI 통합교육에서의 궁극적 목표는 학생들이 실제 윤리적 문제 상황에서 적절한 행동을 취할 수 있도록 하는 것이다. 그러나 현재 학습자의 윤리적 행동에 영향을 미치는 요인 연구와 이를 평가할 도구가 부족한 실정이다[22]. 본 연구는 각 문제해결단계마다 적절한 평가도구를 매핑함으로써 다양한 평가방식 적용을 제안하고 있으나, 전문가들은 단일 형태의 응답방식을 넘어 선택형, 서술형, 순서 배열형, 프로젝트 기반 등 다양한 평가 방식을 통합적으로 활용할 필요성을 제기하였다. 특히 단일 정답이 있는 선택형 문항만으로는 학생들의 윤리적 태도와 가치관을 온전히 평가하기 어렵다는 한계가 있으며, 서술형 문항이나 사고 과정을 드러내는 문항을 통해 학생들의 윤리적 사고 및 의사결정 과정을 심층적으로 파악하는 것이 중요하다는 점이 강조되었다. 또한 AI 윤리 평가에 경제적 영향 관련 내용을 포함할 필요가 있다. 특히 AI 기술이 일자리 변화, 생산성, 디지털 격차 등에 미치는 영향에 대한 이해와 평가가 포함되어야 한다. 이는 학생들이 AI 기술의 사회경제적 영향을 종합적으로 이해하고, 책임 있는 AI 개발과 활용의 중요성을 인식하는 데 도움을 줄 수 있다.

1) 학교 현실을 고려한 유연한 평가체계

전문가들은 학교 현장의 다양한 여건을 고려한 평가도구 설계의 중요성을 강조했다. 특히 경험학습 기반 평가의경우 수업 시간과 과정이 충분히 보장되어야 하기 때문에이를 진행하기 어려운 학교 상황을 고려하여 최소한의 요소로 구성된 간소화된 평가도구가 필요하다는 의견을 제안하였다.

“AI 윤리 역량을 장기적으로 평가하기 위해서는 개별 학교의 상황에 따라 약식 버전 또는 전체 버전 등으로 구분하여 측정할 수 있는 방안도 고려해볼 필요가 있습니다. 특히 경험학습 기반 평가의 경우 수업 시간과 과정이 충분히 보장되어야 하기 때문에 이를 진행하기 어려울 수도 있어 보입니다.” (전문가 A)

“장기적인 프로젝트 수업이 이루어져야 할 것 같습니다. 수업 시수 등 현실적인 문제를 고려하였을 때 최소한의 요소들로 측정할 수 있도록 간소화하는 형태로 가야 현장 적용이 용이할 것 같습니다.” (전문가 F)

본 연구에서 제안된 AI 통합교육에서의 윤리역량 평가는 네가지의 평가 유형이 독립적으로 사용되는 것이 아니라 문제해결 각 단계마다 선별적으로 적용되는 통합적 체계이다. 이에 각 단계별 소요 시간, 필요 자원, 준비 사항등을 제시하고, 상황에 따라 일부 단계만 선택적으로 적용할 수 있는 유연한 옵션 제공이 필요하다. 또한 학교 현실을 고려한 유연한 평가체계를 위해 모듈식 또는 단계별 평가 체계 개발이 필요하다. 기본 평가에서는 시나리오 기반의 도덕적 발달 평가와 역량기반 평가를 조합하여 지식 및기본적인 판단 능력을 평가할 수 있다. 심화평가에서는 기본 평가에 개인의 선호와 가치과을 파악하는 입서티브 유형의 평가와 실제 AI 윤리 문제를 경험하고 해결해나가는경험학습 기반 평가를 추가하여 보다 종합적인 평가가 진행될 수 있다.

2) 학생 수준별 차별화된 평가도구

전문가들은 학생들의 발달 수준과 학교급에 따른 차별화된 평가도구의 필요성을 강조했다. 이러한 의견들은 학생들의 인지적, 발달적 특성을 고려한 맞춤형 평가 방식의 필요성을 시사한다. 따라서 중학생은 보다 기본적인 AI 윤리 개념과 원칙을 중심으로 평가하고, 고등학생에게는 복잡한 윤리적 딜레마와 가치 판단을 요구하는 평가가 필요하다. 예를 들어 중학생의 경우 “AI 추천 시스템이 특정 그룹에게 불리한 결과를 제공한다면, 이는 어떤 AI 윤리 원칙과 관련이 있는가?” 의 문항이 될 수 있다. 고등학생의 경우 “AI 추천 시스템이 사회적 약자에게 불리한 결과를 제공하지만, 전체적인 효율성은 높아지는 상황에서 우리는 어떤 가치를 우선시해야 하며, 그 이유는 무엇인가?” 로 서술식을 통해 학습자의 역랑을 수준을 판단할 수 있다.

“지식, 기능, 태도 영역 구성인 윤리 평가가 타당하다고 보며, 중학생 수준에는 적합하나, 고등학생 수준에서 쉬운 문항으로 보입니다. 복잡한 윤리적 상황을 제시하거나, 가치 판단이 필요한 질문을 제시할 필요가 있습니다.” (전문가 E)

“콜버그의 도덕발달이론에서는 후인습적 수준을 가장 높은 단계로 설정하고 있습니다. 이 평가도구는 학생들이 5단계 수준(사회 계약 지향)의 AI 윤리 역량을 함양하도록 설계된 것으로 보입니다. 평가 문항에서 4번 선지가 가장 옳은 선지로 상정되어 있는데, 이러한 도구를 통해 학생들의 발달 단계를 진단한 후에는 후속 교수학습 방안이 필요할 것입니다. 특히 서로 다른 AI 윤리 발달 단계에 있는 학생들이 함께 토론하도록 하여 블래트 효과를 도모하는 등의 교육적 개입이 효과적일 수 있습니다. 학생들의 도덕적 추론 능력을 한 단계 높은 수준으로 발전시키기 위한 구체적인 교수학습 방안이 평가도구와 함께 제시되면 더욱 의미 있는 평가가 될 것입니다.” (전문가 F)

전문가가 제시한 ‘블래트 효과’를 활용한 교육적 접근도 고려할 수 있다. Blatt와 Kohlberg(1974)의 연구에서는 서로 다른 도덕적 발달 단계에 있는 학생들 간의 토론이 도덕적 성장을 촉진함을 증명했다[23]. AI 통합교육 중간 단계에서의 평가 결과를 바탕으로 서로 다른 도덕적 발달 단계에 있는 학생들 간의 토론이나 협력 활동을 구성하여 학습자의 도덕적 발달을 촉진할 수 있다. 예를 들어, 4단계(사회 질서 지향)의 학생과 5단계(사회 계약 지향)의 학생을 함께 그룹으로 묶어 AI 윤리 문제에 대해 논의하게 함으로써 4단계에 해당하는 학생의 도덕적 발달을 촉진할 수 있다.

전문가들은 평가 결과의 효과적인 제공과 활용 방안이 중요하다고 지적했다. 구체적으로 학생들의 AI 윤리 역량의 성장과 발달을 지속적으로 모니터링하고 지원할 수 있는 평가 결과 제공 방식이 중요하다는 점이 강조되었다.

“평가 결과 해석에서 이전 평가 결과와의 비교 또는 집단 평균과 개인의 비교 등의 내용이 포함되면 좋겠습니다.” (전문가 A)

“평가 결과를 바탕으로 학습자에게 도덕적 추론 수준을 점수화하기보다는 구체적 피드백과 단계 상승을 위한 학습 전략을 제공해 주는 것이 더 의미 있을 것 같습니다. 또한 평가 결과를 해석하고 피드백을 제공할 때 각 점수대별 피드백, 보완활동 제안된 교사·평가자용 매뉴얼이 함께 제공되면 실효성이 더욱 높아질 것 같습니다. 윤리가 실천으로 이루어지게 하기 위해 행동과 생각의 괴리를 줄이기 위한 피드백 모델이 추가된다면 유의미한 결과가 될 것 같습니다.” (전문가 D)

본 연구에서 제안된 AI 통합교육에서의 윤리역량 평가는 문제해결과정의 각 단계에 적합한 평가도구들을 구조화하여 배치하고 단계별로 윤리역량을 측정하는 특징을 갖고 있다. 이러한 평가체계는 학습자의 발달을 순차적으로 파악할 수 있도록 설계되어 이전 평가 결과와의 비교를 통한 역량 향상을 추적할 수 있다는 장점이 있다. 구체적으로 AI 윤리 역량 요소별 변화를 그래프로 시각화하여 성장 궤적을 직관적으로 파악할 수 있도록 설계할 수 있다. 이를 통해 교수자는 학습자의 AI 윤리 역량 발달의 방향성과 속도를 인식할 수 있으며, 필요한 경우 적절한 교육적 적용 시점을 결정할 수 있다. 학습자는 이전에 비해 향상된 점, 향상된 이유 등의 자기 성찰 질문을 수행함으로써 학생 스스로 자신의 발달 과정을 인식하고 성장 목표를 설정하도록 지원할 수 있다. 또한 AI 윤리 역량 수준을 초급, 중급, 고급으로 설정하고 각 평가 영역별로 수준별 성취 기준을 기술한 루브릭 개발이 필요하다. 이러한 루브릭은 학년 또는 학교급별 기대하는 성취 수준을 제시하기 때문에 교사는 수업 목표와 내용을 설계하는데 활용할 수 있으며, 학생은 다음 단계 발달을 위한 명확한 학습 목표 설정이 가능하다.

5. 결론 및 제언

본 연구는 AI 통합 교육에서 AI 윤리 역량을 종합적으로평가할 수 있는 평가도구의 개발 방향을 탐색하기 위해 전문가 포커스 그룹 인터뷰를 실시하고, 정량적·정성적 분석을통해 평가도구의 개발 방향을 도출하였다.

전문가들은 AI 윤리역량 평가도구 개발에 있어 다음과 같은 방향성을 제시하였다. 첫째, AI 윤리 역량의 개념과 하위 요소에 대한 구체적인 정의와 체계화가 필요하다. AI 윤리원칙에 대한 지식, 윤리적 이슈 분석 및 대응 기능, 가치관 및 책임감과 같은 태도, 실제 상황에서의 윤리적 행동 등을 통합적으로 평가할 수 있는 프레임워크가 필요하다. 특히 생성형 AI와 같이 학생들이 실제로 접하는 최신 기술 환경을 반영해야 한다.

둘째, 학교 현장의 다양한 여건을 고려한 유연한 평가체계가 필요하다. 모듈식 구성으로 기본 평가와 심화 평가를 구분하여 학교 상황과 학생 수준에 맞게 선택적으로 활용할 수있도록 설계해야 한다. 중학생과 고등학생의 인지적, 발달적특성을 고려한 차별화된 평가도구도 요구된다.

셋째, 실제성을 강조한 평가가 이루어져야 한다. 인위적인 시나리오나 데이터셋보다는 실제 AI 시스템에서 발생할 수 있는 윤리적 딜레마 상황을 활용함으로써 학생들의 문제해결능력과 윤리적 감수성을 효과적으로 평가할 수 있다. 안내된 교수(guided instruction)를 통해 학생들의 자기주도적 학습과 컴퓨팅 사고력 함양을 지원해야 한다.

넷째, 선택형, 서술형, 프로젝트 기반 등 다양한 평가 방식을 통합적으로 활용해야 한다. 특히 AI 기술의 사회경제적 영향에 대한 이해를 포함하여 AI 윤리역량을 포괄적으로 평가할 필요가 있다. 이를 통해 학생들의 윤리적 태도와 가치관을 보다 심층적으로 파악할 수 있다.

다섯째, 학습자의 지속적인 성장을 지원하는 평가 결과 제공 방식이 중요하다. 역량 변화의 시각화, 이전 평가 결과와의 비교, 맞춤형 피드백 등을 통해 학생들의 자기 성찰과 성장을 촉진해야 한다. 특히 ‘블래트 효과’를 활용하여 서로 다른 도덕적 발달 단계에 있는 학생들 간의 상호작용을 통해 윤리적 발달을 촉진하는 교육적 접근도 고려할 필요가 있다.

본 연구는 AI 통합교육에서의 윤리역량 평가 방향을 제시했다는 점에서 의의가 있으나, 실제 개발된 평가도구의 현장 적용과 효과성 검증이 이루어지지 않았다는 제한점이 있다. 향후 연구에서는 본 연구에서 제안한 방향성을 바탕으로 구체적인 평가도구를 개발하고, 이를 실제 교육현장에 적용하여 타당성과 효과성을 검증할 필요가 있다. 또한 AI 기술의 빠른 발전에 따라 새롭게 등장하는 윤리적 이슈들을 지속적으로 반영할 수 있는 유연한 평가체계 구축에 대한 연구가 지속되어야 할 것이다. 이를 통해 학생들이 AI 기술의 발전과 함께 윤리적 판단력과 책임감을 함양하고, 미래사회에서 요구되는 디지털 시민으로서의 역량을 갖출 수 있도록 지원해야 할 것이다.

Acknowledgments

본 논문은 2021년 대한민국 교육부와 한국연구재단의 지원을 받아 수행된 연구임(NRF-2021S1A5C2A04088646)

본 논문은 2024년 제54회 한국컴퓨터교육학회 하계 학술대회에서 “인공지능 통합교육에서 인공지능 윤리 역량 평가 방법 탐색”의 제목으로 발표된 논문을 확장한 것임.

References

-

Miao, F., & Shiohira, K. (2024). AI competency framework for student. UNESCO.

[https://doi.org/10.54675/JKJB9835]

-

Jang, S. (2023). ChatGPT has Changed the Future of Writing Education:Focusing on the response of writing education in the era of artificial intelligence. Writing Research, 56, 7–34.

[https://doi.org/10.31565/korrow.2023..56.001]

-

Bae, J., & Cho, J. (2024). Development of an Integrated Artificial Intelligence Education Program Based on Blended Learning. Intelligent Information Convergence and Future Education, 3(3), 3-54.

[https://doi.org/10.59482/iicfe.2024.3.3.05]

-

Kim, T., & Byun, S. (2021). A Study on the Necessity and Content Composition of AI Ethics Education. Journal of AI Humanities, 8, 71-104.

[https://doi.org/10.46397/JAIH.8.4]

-

Bae, J., Lee, J., Hong, M., & Cho, J. (2022). The Development of AI Ethical Competence Scale for Secondary School Students. The Journal of Korean Association of Computer Education, 25(6), 103-118.

[https://doi.org/10.32431/kace.2022.25.6.008]

-

Jung, D., & Park, H. (2023). Development and Implementation of an Elementary-school AI Ethics Education Program. Korean journal of elementary education, 34(3), 39-54.

[https://doi.org/10.20972/kjee.34.3.202309.39]

-

Hong, E., & Oh, K . (2024). Development and Effectiveness Analysis of Ethical Dilemma Scenario for Artificial Intelligence Ethics Education: Inquiry of Moral Machine Alternatives. The Journal of Korean Association of Computer Education, 27(2), 109-119.

[https://doi.org/10.32431/kace.2024.27.2.010]

-

Kim, E., & Lee, Y. (2023). Development of AI Ethics Dilemma to Enhance AI Ethical Competence. The Journal of Korean Association of Computer Education,, 26(5). 31-42.

[https://doi.org/10.32431/kace.2023.26.5.003]

- Bae, J. (2023). Development of an integrated artificial intelligence education program embedding ethics. [Doctoral dissertation]. Jeju National University.

- Bae, J., Choe, J., & Cho, J. (2024). Proposed Methods for Evaluating AI Ethics Competencies in Integrated AI Education. Proceedings of the Korea SoftwareCongress 2024, Yeosu, South Korea, 947-949.

- Lee, J., Kim, Y., Hyun, J., & Rue, D. (2000). A study on the analysis of developmental level about the cognitive and affective characteristics : focused on the 1st-9th grade students. [Research Report RR-2000-9]. Korea Educational Development Institute.

-

Park, M. (2009). Analysis of the characteristics of competence-based curriculum and its critical issues. The Journal of Curriculum Studies. 27(4), 71-94.

[https://doi.org/10.15708/kscs.27.4.200912.004]

- Kwon, E. (2019). Development and Validation of Honesty Test using Situational Judgment Test Format. [Doctoral dissertation]. Daegu University.

- Krueger, R., & Casey, M. (2014). Focus groups: A practical guide for applied research(Min, B & Cho, D., Trans.). Seoul: Myungin Publishing.

- Kim, S. Kim, H., Lee, K., & Lee, S. (2000). Focus Gruoup Research Method(Second). Seoul: Hyunmoon Publishing Co.

-

Glaser, B., & Strauss, A . ( 2017). The discovery of grounded theory: Strategies for qualitative research. Routledge, New York .

[https://doi.org/10.4324/9780203793206]

-

Douglas, E. (2002). Qualitative analysis: Practice and innovation. Routledge, London.

[https://doi.org/10.4324/9781315015484]

-

Lincoln, Y., & Guba, E. (1985). Naturalistic inquiry. Sage Publications.

[https://doi.org/10.1016/0147-1767(85)90062-8]

-

Stake, R. (2010). Qualitative research: Studying how things work. Guilford Press.

[https://doi.org/10.3138/cjpe.026.007]

-

Bruneault , F., Laflamme, A ., & Mondoux, A . (2022). AI Ethics Training in Higher Education: Competency Framework.

[https://doi.org/10.13140/RG.2.2.28456.65280]

-

Zendler, A. (2019). Teaching Methods for Computer Science Education in the Context of Significant Learning Theories. International Journal of Information and Education Technology. 9. 470-476.

[https://doi.org/10.18178/ijiet.2019.9.7.1248]

-

Kim, E., & Lee, Y. (2024). A Study on the Development of AI Ethics Sensitivity Scale. The Journal of Korean Association of Computer Education, 27(3). 155-168.

[https://doi.org/10.32431/kace.2024.27.3.014]

-

Blatt, M., & Kohlberg, L. (1975). The Effects of Classroom Moral Discussion upon Children’s Level of Moral Judgment. Journal of Moral Education, 4, 129-161.

[https://doi.org/10.1080/0305724750040207]

Appendix

부 록

· 2003 한국방송통신대학교 컴퓨터과학(이학사)

· 2020 제주대학교 컴퓨터교육전공(교육학석사)

· 2023 제주대학교컴퓨터교육전공(교육학박사)

· 2023년~현재 제주대학교 지능소프트웨어교육연구소 학술연구교수

관심분야 : 정보·컴퓨터(SW·AI), 인공지능윤리, 디지털 격차해소

jina@jejunu.ac.kr

· 2006 제주대학교 컴퓨터공학과(공학사)

· 2011 한양대학교 교육공학과(교육학석사)

· 2024~현재 제주대학교 컴퓨터교육전공 박사과정

관심분야 : SW·AI교육, 인공지능 윤리, 교수·학습

jahchoe@gmail.com

· 2004년~현재 제주대학교 컴퓨터교육과교수

· 2020년~현재 한국컴퓨터교육학회부회장, 논문지 편집위원장

· 2012년~현재 한국정보과학회 부회장, 전산교육시스템연구회 위원장

· 2018년~현재 제주대학교 지능소프트웨어교육연구소 연구소장

관심분야 : 정보·컴퓨터(SW, AI)교육, 지능정보윤리, 지능형시스템, 멀티미디어

jwcho@jejunu.ac.kr